BigQuery: Search Console Daten automatisiert speichern

21. März 2023

Seit dem 21. Februar 2023 können Nutzer:innen der Google Search Console ihre Daten täglich automatisch in der Google BigQuery-Datenbank archivieren lassen. Wer allerdings noch nicht so richtig mit der Google-Datenbank vertraut ist, den stellt das Archivieren der Daten vor eine größere Herausforderung. Aus diesem Grund wollen wir in diesem Blogartikel Schritt für Schritt erklären, wie ihr ein Projekt in der Google Cloud erstellt und die Daten anschließend von der Search Console an BigQuery sendet.

Wer diesem How to folgt, wird es am Ende erheblicher leichter haben, die eigenen Search Console Daten zu archivieren und zusätzlich die Möglichkeit nutzen können, sich ohne Programmierkenntnisse ein kleines Keyword-Data-Warehouse einzurichten.

Inhaltsverzeichnis

ToggleDarum solltet ihr eure Search Console Daten in BigQuery archivieren

Im Bereich der SEO-Optimierung von Websites stellt die Google Search Console eine wichtige Datenquelle dar. Das Problem: Die Daten werden hier nur für 16 Monate gespeichert, was die Betrachtung der Zahlen über einen längeren Zeitraum hinweg ausschließt.

Hinzu kommt, dass das User Interface der Search Console auf 1.000 Zeilen Export beschränkt ist – und das reicht selbst für kleinere Websites oft nicht aus.

Doch Google bietet nun eine Lösung an: Die automatische Speicherung von Daten in BigQuery ermöglicht sowohl eine längere Speicherdauer als auch Analysen und Exporte mit mehr als 1.000 Zeilen!

Wir zeigen euch daher nachfolgend Schritt für Schritt, wie ihr eure Search Console Daten automatisiert in BigQuery speichern könnt.

Schritt 1: Erstellen eines Projektes und Aktivieren der BigQuery API

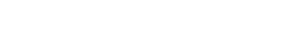

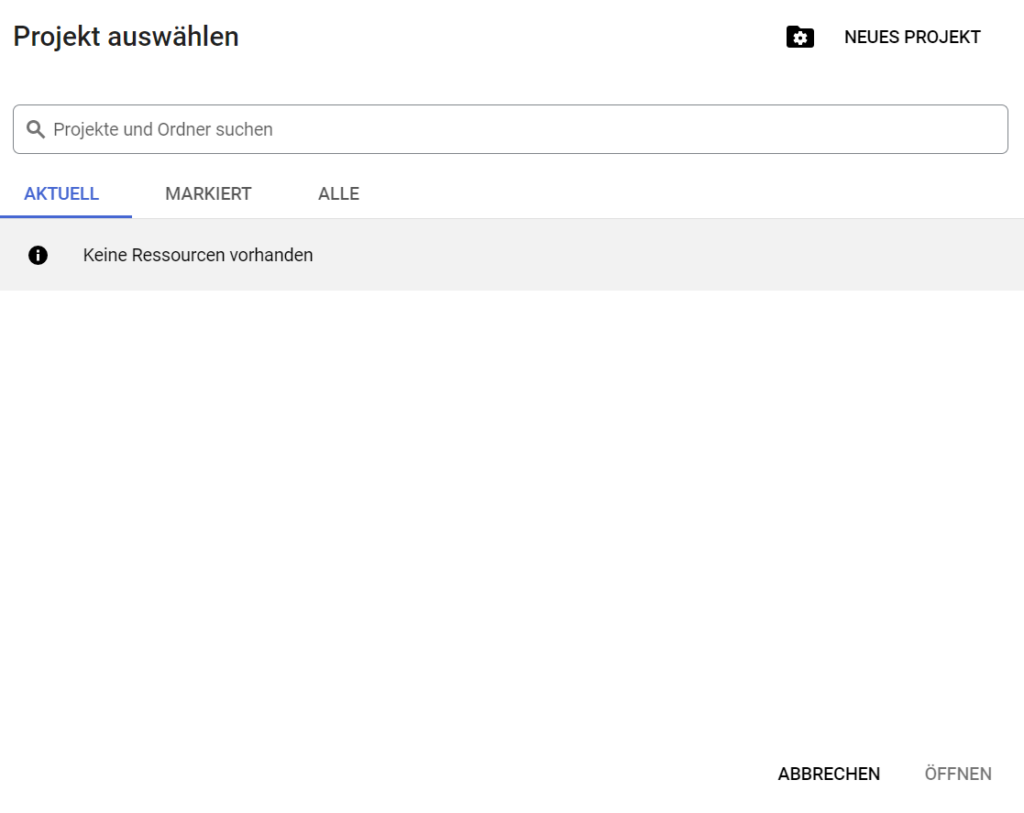

Als Erstes logt ihr euch mit euren gewohnten Google-Zugangsdaten auf https://console.cloud.google.com/ ein. Anschließend wählt ihr entweder ein bestehendes Projekt aus oder ihr erstellt ein neues.

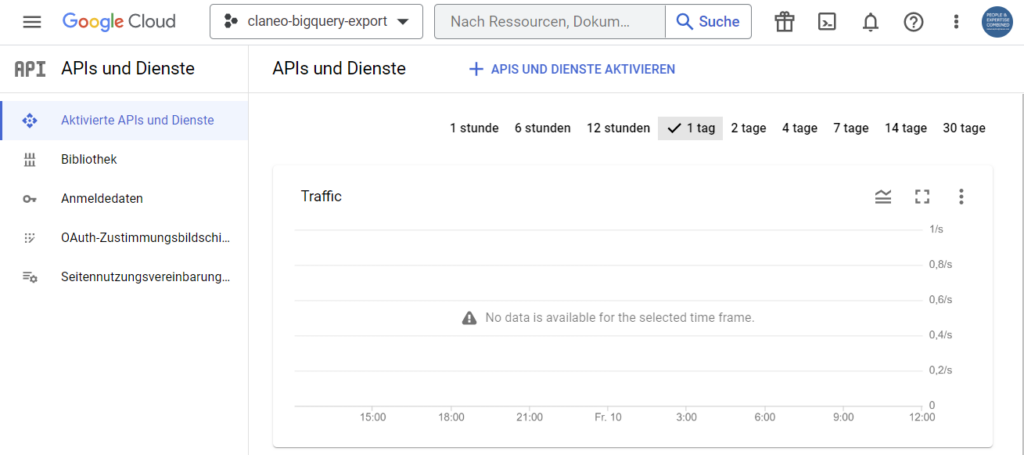

Weiterführend wählt ihr im Menü oben links „APIs und Dienste“ aus und dann „Aktivierte APIs und Dienste“. Auf der Seite, die sich daraufhin öffnet, klickt ihr nun auf „APIs und Dienste aktivieren“.

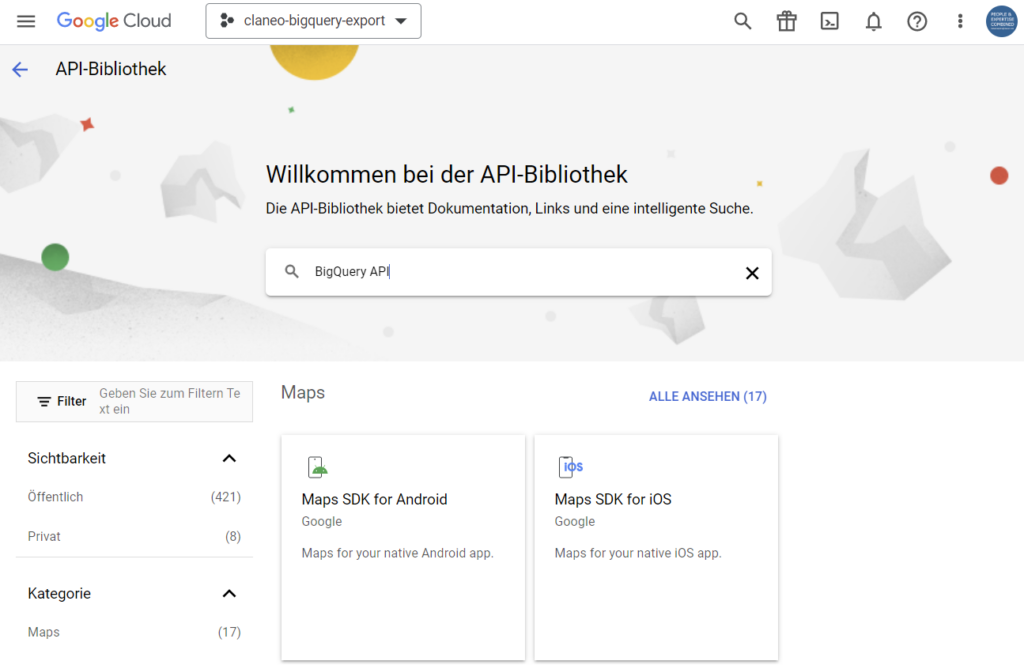

Durch diesen Klick erscheint die Seite der API-Bibliothek, in deren Suchfeld ihr einfach „BigQuery API“ eingebt und im Anschluss das passende Suchergebnis auswählt.

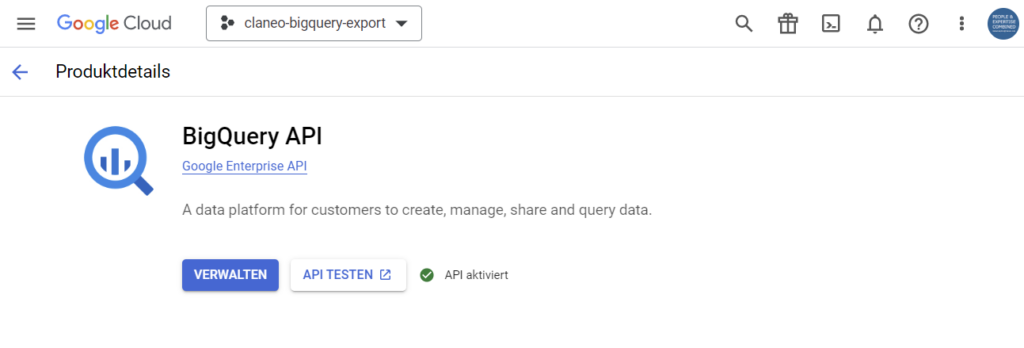

Als nächstes klickt ihr auf „API aktivieren“, was durch das Erscheinen eines grünen Häkchens bestätigt wird.

Schritt 2: Autorisieren des Zugriffs von der Search Console auf BigQuery

Da die Search Console die Daten erst nach einer erfolgreichen Autorisierung an BigQuery übertragen kann, müsst ihr der Search Console noch den Zugriff auf das entsprechende Projekt ermöglichen. Dies funktioniert wie folgt.

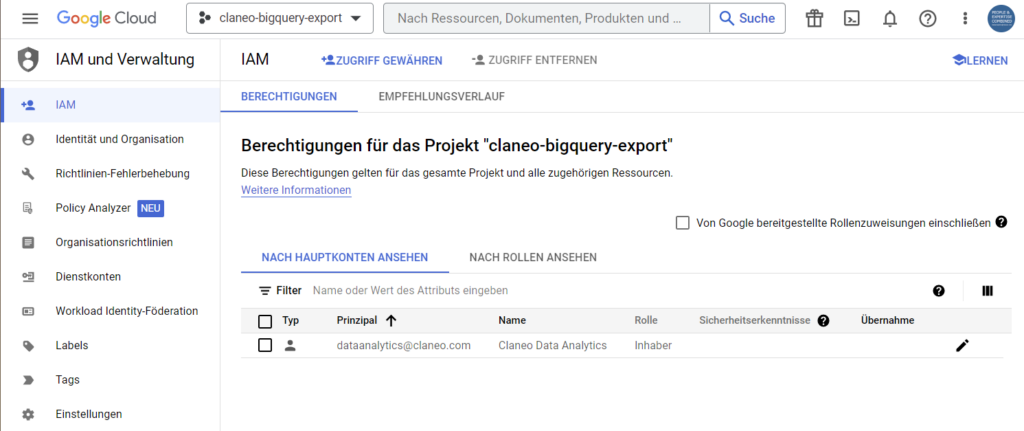

Über das Menü oben links gelangt ihr zu dem Punkt „IAM & Verwaltung“, aus dessen Untermenü ihr „IAM“ auswählt.

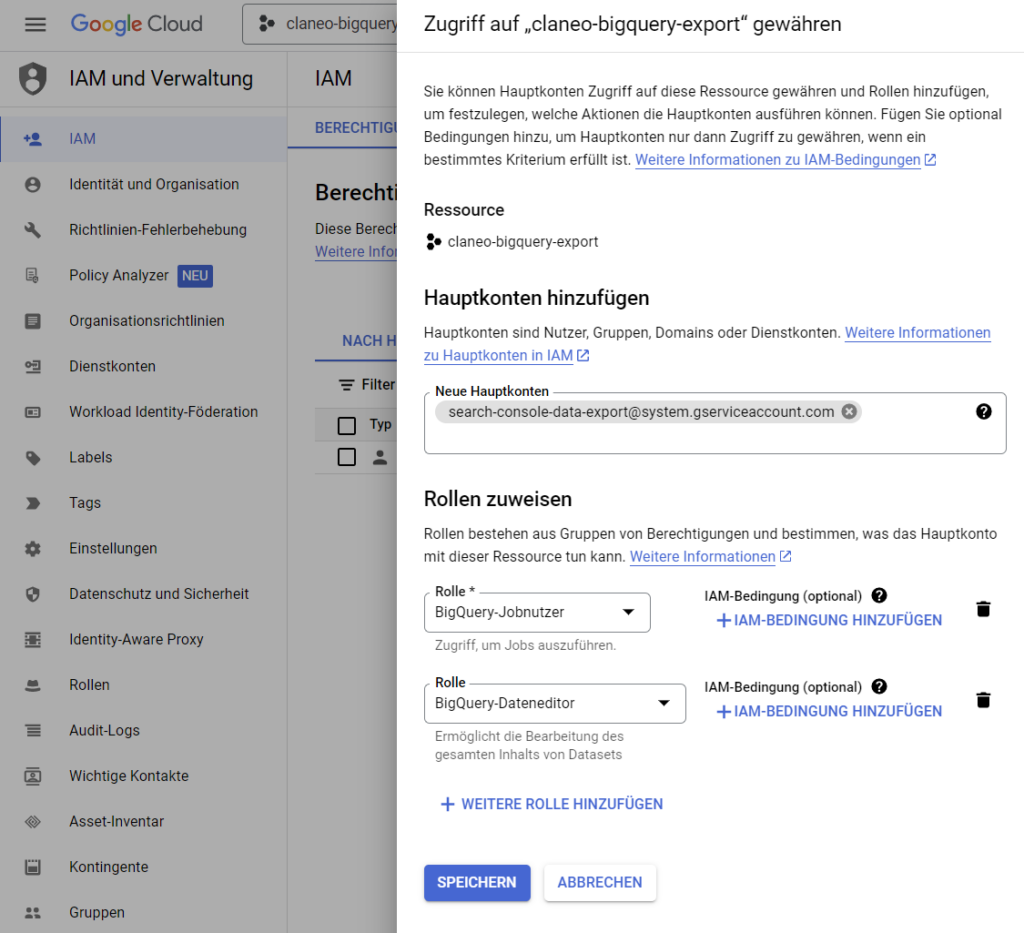

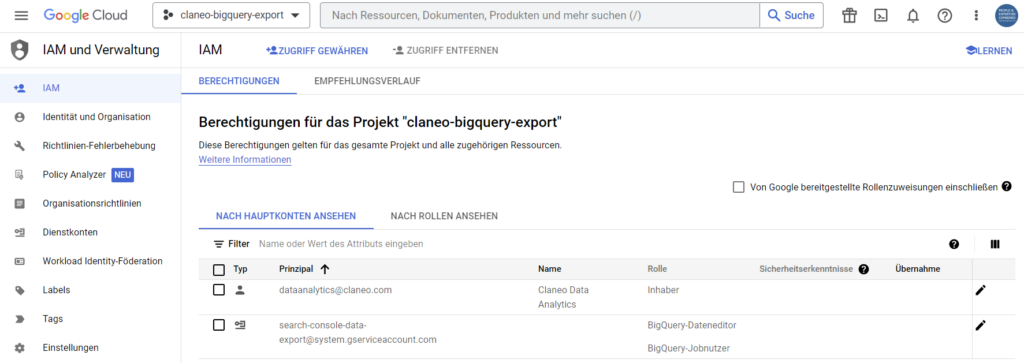

Hier klickt ihr dann auf „Zugriff gewähren“. Beachtet dabei allerdings, dass zunächst ein neue Hauptkonto hinzugefügt werden muss, welches über Rollen verfügt, mittels derer die Daten aus der Search Console an BigQuery übertragen werden können.

Berücksichtig zudem, dass die von Google vorgegebenen Daten exakt übernommen werden und im Anschluss gespeichert werden müssen:

- Hauptkonto: search-console-data-export@system.gserviceaccount.com

- Rolle 1: BigQuery-Jobnutzer

- Rolle 2: BigQuery-Dateneditor

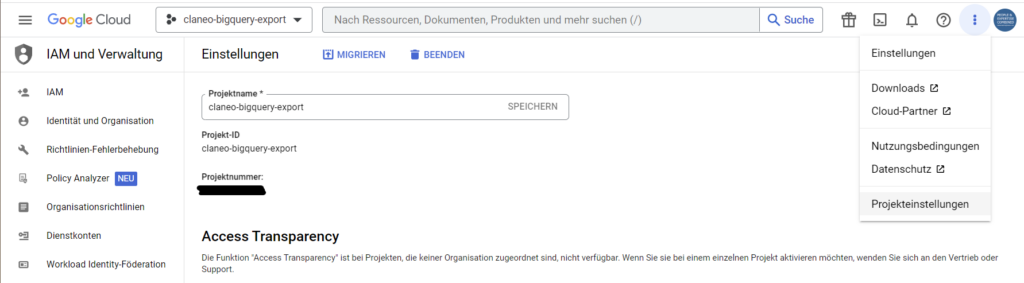

Darüber hinaus solltet ihr euch die ID des Projektes notieren, die ihr oben rechts im Menü durch einen Klick auf „Projekteinstellungen“ findet.

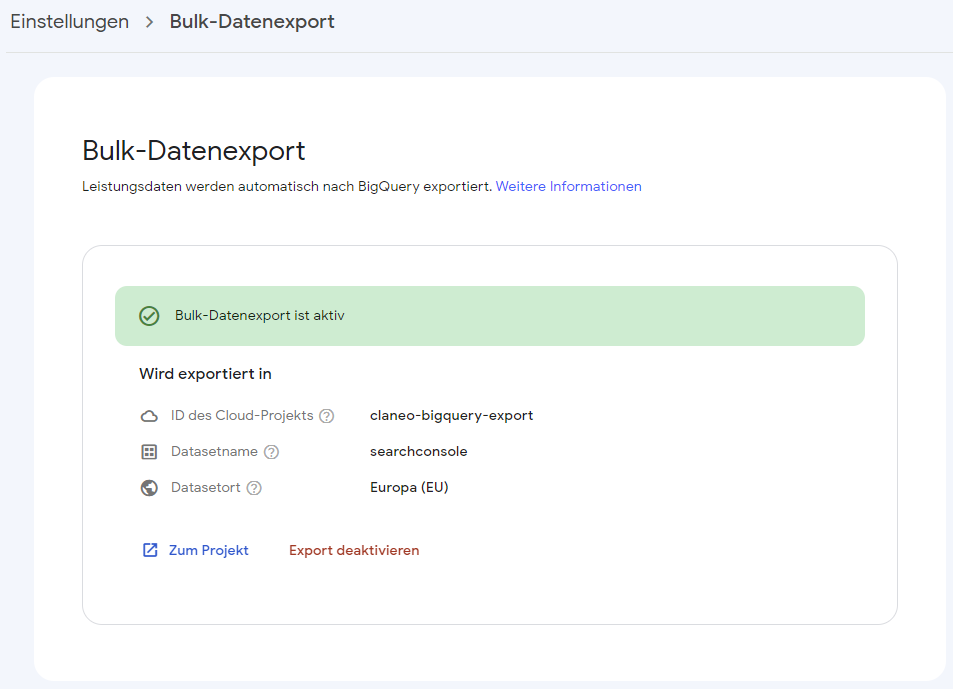

Schritt 3: Einrichten des Bulk-Datenexports

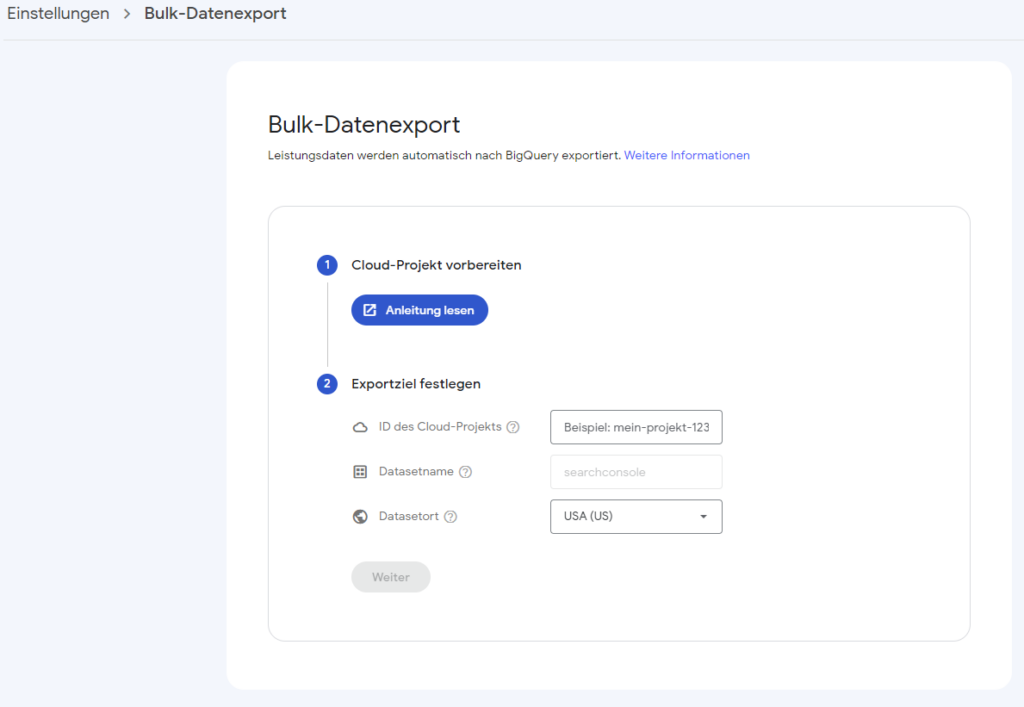

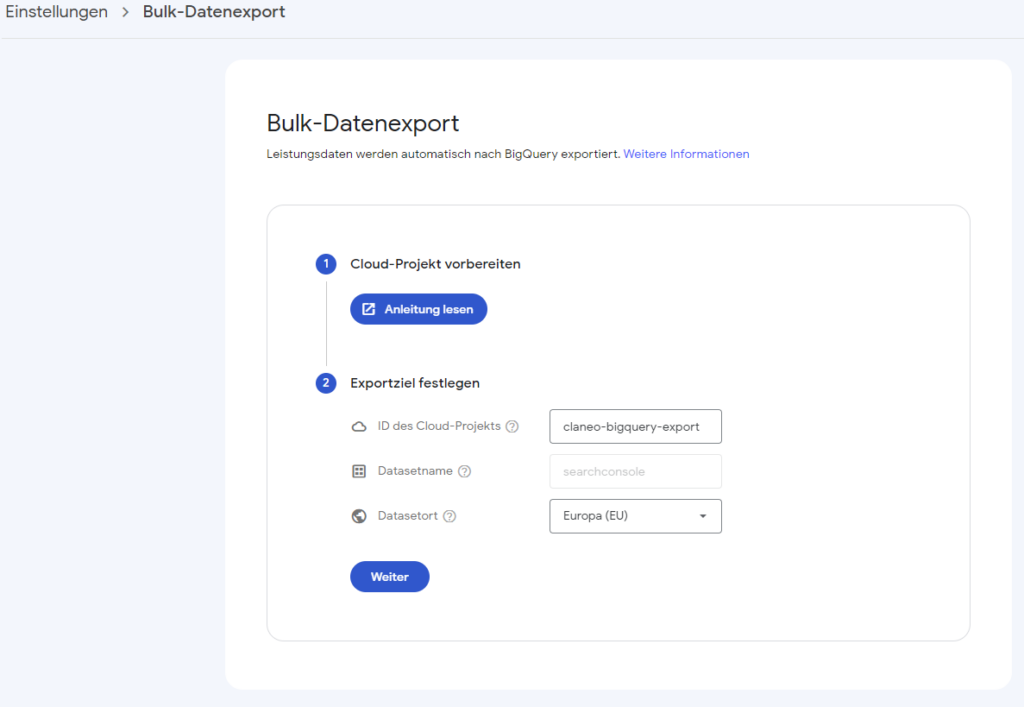

Wenn ihr die vorherigen Schritte erfolgreich abgeschlossen habt, seid ihr bereit für das Einrichten des Exports von der Google Search Console zu BigQuery. Dazu navigiert ihr in der Search Console unter Einstellungen zu dem Punkt „Bulk-Datenexport“.

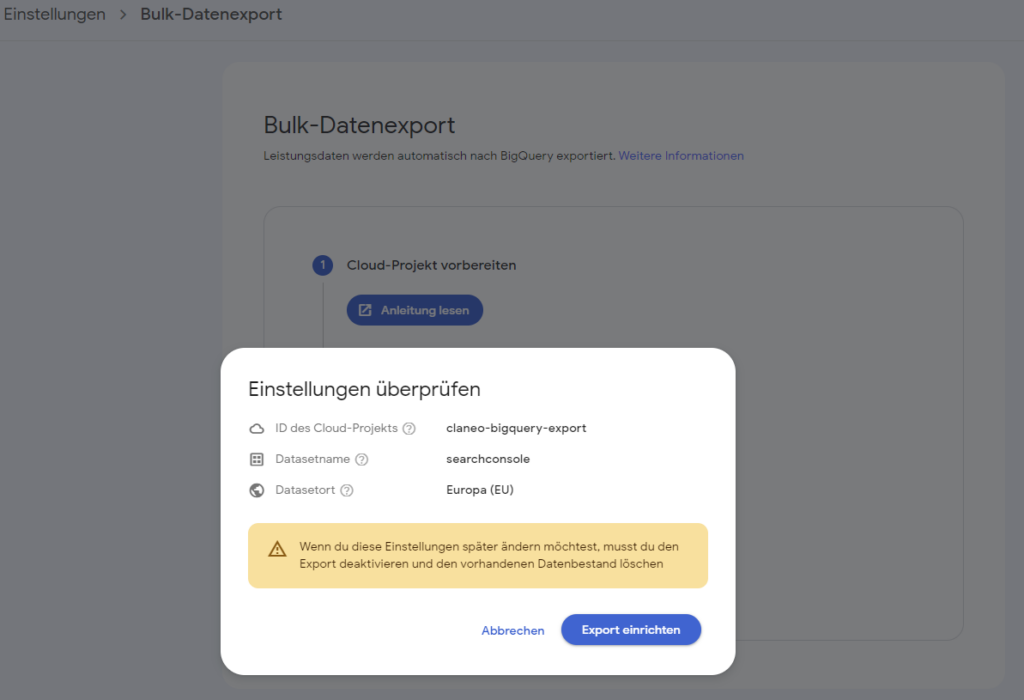

An dieser Stelle kommt eure Projekt-ID zum Einsatz. Diese tragt ihr zusammen mit eurem Datenstandort (meistens Europa) in die entsprechende Zeile ein und kontrolliert das Ganze noch einmal, bevor ihr die Datenübertragung einrichtet.

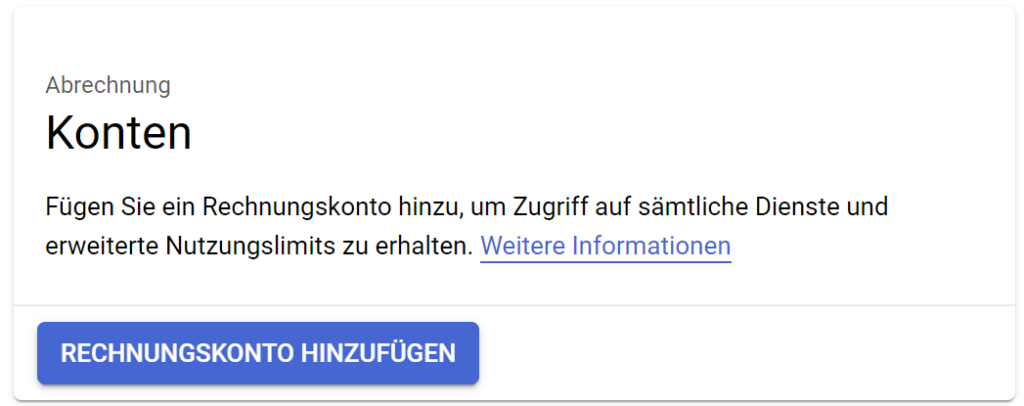

Schritt 4: Festlegen der Zahlungsinformationen

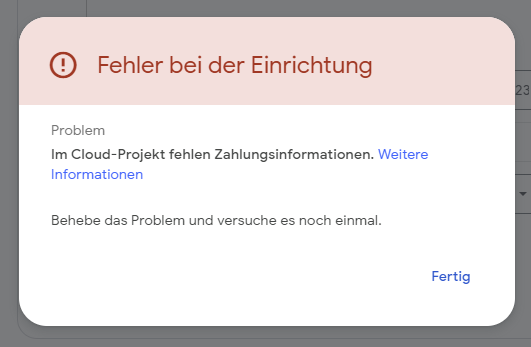

Da es sich bei BigQuery um einen zahlungspflichtigen Dienst handelt, wird euch wahrscheinlich beim Einrichten der Datenübertragung – sofern kein Zahlungskonto hinterlegt ist – eine Fehlermeldung angezeigt.

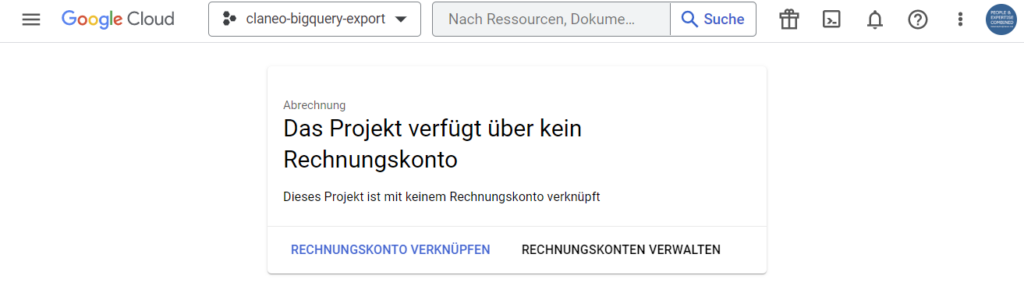

Zahlungsinformationen lassen sich jedoch ganz einfach hinterlegen: Dazu kehrt ihr zu eurem Google Cloud Projekt zurück und wählt dort den Menüpunkt „Abrechnung“ aus.

Nachdem sich eine Seite geöffnet hat, die darauf hinweist, dass das Projekt über kein Rechnungskonto verfügt, klickt ihr hier auf „Rechnungskonto verknüpfen“.

Darauf folgt ein weiterer Hinweis, laut dem ihr ein neues Rechnungskonto erstellen sollt.

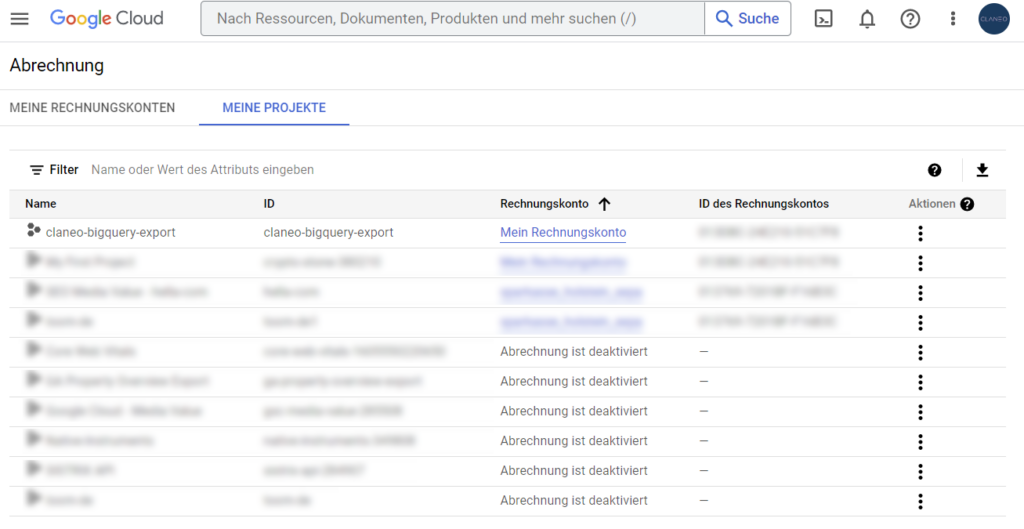

Beim Durchlaufen dieses Prozesses gebt ihr zunächst eure Zahlungsinformationen an, wodurch ein neues Zahlungskonto mit dem Projekt verknüpft wird. Nachprüfen könnt ihr das bei dem Menüpunkt „Abrechnung“ unter „Rechnungskonto verwalten“. Hier sollte dann im besten Fall das Projekt angezeigt werden, dass ihr für den BigQuery Export eurer Search Console Daten erstellt habt. Dies ist in jedem Fall Voraussetzung für eine erfolgreiche Datenübertragung.

Um die Daten nun übertragen zu können, müsst ihr zur Search Console zurückgehen und einen erneuten Versuch starten, den Bulk-Export einzurichten. Das sollte euch nun problemlos gelingen.

Über den dort angezeigten Link „Zum Projekt“ gelangt ihr dann direkt zu BigQuery und den dort gespeicherten Daten.

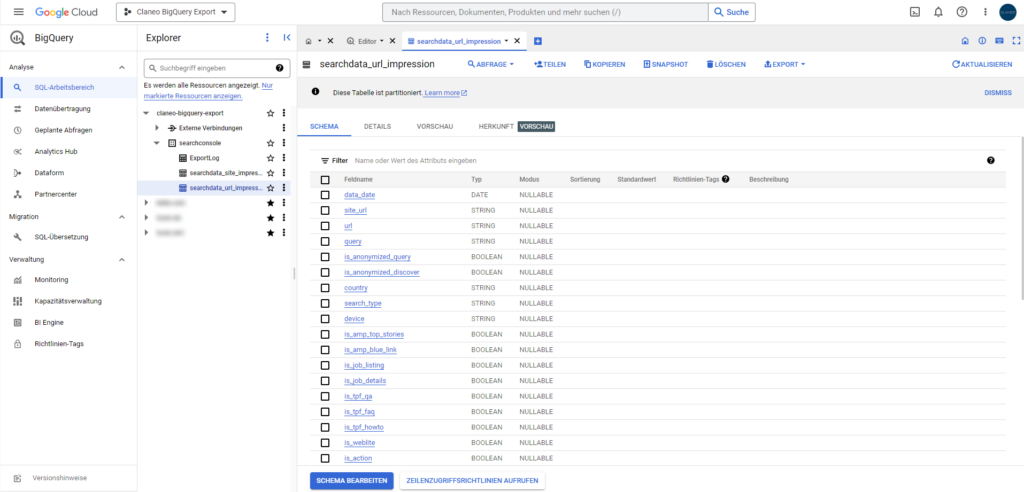

URL- und Keyword-Daten in BigQuery

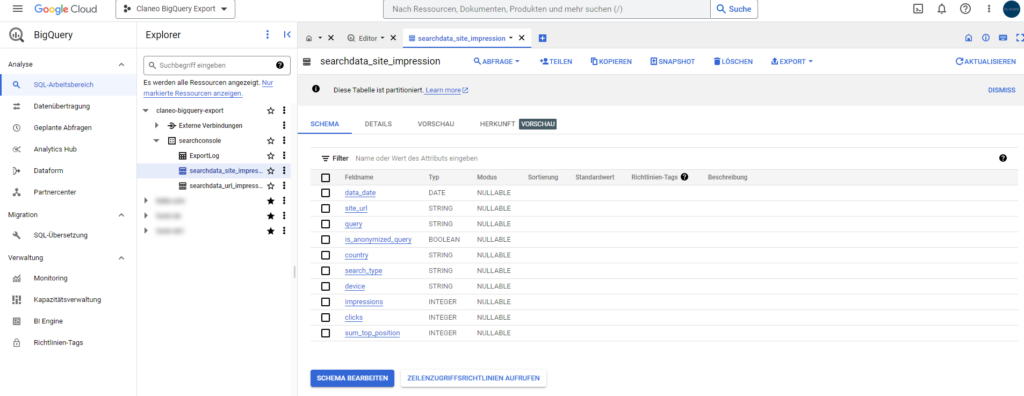

Nach erfolgreicher Einrichtung von BigQuery solltet ihr dort etwa 1-2 Tage später einen täglichen Export eurer Search Console Daten finden. Diese werden in zwei verschiedenen Tabellen dargestellt, unterteilt in URL-Daten und Keyword-Daten.

URL-Daten

Die Tabelle „searchdata_url_impression“ zeigt alle URLs und die dazugehörigen Keywords an, die mindestens eine Impression generiert haben und nicht von Google herausgefiltert wurden.

Keyword-Daten

In der Tabelle „searchdata_site_impression“ werden hingegen ausschließlich Keyword-Daten dargestellt.