SEOkomm 2024 Recap: Badda Boom Badda Bang

2. Dezember 2024

„SEOs komm again nach Salzburg zum häng, hier trifft sich die gang“ – mit diesem Song von Björn Darko startete die diesjährige SEOkomm und so ging sie auch weiter – wer die SEOkomm kennt, weiß das. Neue Location direkt im Zentrum Salzburgs, leichter Schneefall vor der Tür und hochkarätige SEOs (einschließlich unserer eigenen zwei Speaker) mit spannenden Vorträgen und Insights. Inspiriert von unserem Kollegen Steffen und seinem Bericht vom SEODay haben wir auch einmal geschaut, in wie vielen Vortragstiteln AI vorkam; es waren erstaunlicherweise nur drei. Viel spannender war hingegen, dass es in den meisten Vorträgen zwar grundsätzlich um andere Themen ging, dass KI aber inzwischen überall eine Rolle spielt und so auch in fast jedem Vortrag vorkam – aber eben nicht unbedingt als zentrales Thema.

Und das beschreibt auch einen der Kernpunkte der SEOkomm ganz gut: AI ist da und man kommt nicht mehr um sie herum. Daran haben sich inzwischen alle gewöhnt und versuchen nun, AI für sich zu nutzen. Richtig so!

Weitere Key-Take-aways, die gleich von mehreren Speakern hervorgehoben wurden:

- Kümmert euch um eure Produktseiten und das Merchant Center.

- Stärkt eure Brand.

- Automatisiert eure Prozesse und nutzt KI für euch – ach so, hatten wir ja schon.

Inhaltsverzeichnis

ToggleKeynote: The Future is WHAT? (Bastian Grimm)

In der diesjährigen Keynote ging Bastian Grimm zu Beginn auf die vielen Ereignisse in der SEO-Welt im Jahr 2024 ein. Dazu gehören die Google Leaks, der Wechsel in der Chef-Etage der Google-Suche, die Anhörung des US-Justizministeriums und die damit einhergehende Überlegung, Google zu zerschlagen. Natürlich gab es auch einige Anpassungen in der KI-Welt. Grimm betonte in seinem Vortrag, wie sich Suchmaschinen und SERPs durch KI und personalisierte Inhalte verändern. Google setzt verstärkt auf interaktive Features wie AI-gestützte Shopping-Transformationen, Content-Interaktion (z. B. Google Learn About oder NotebookLM) und Agentic AI, um gegen Konkurrenten wie Amazon anzutreten. Die Rolle der Produktseiten wird daher enorm zunehmen, während Produktlisten (oder Kategorieseiten) zunehmend an Bedeutung verlieren – deren Aufgabe übernimmt Google. Gleichzeitig bleibt die Markenpräsenz essenziell, da Markenbekanntheit nicht nur die Conversion-Raten erheblich steigert (um das 2,9-fache), sondern auch Einfluss auf das Ranking hat. SEO und Branding müssen künftig also stärker miteinander verknüpft werden. Zudem sollte, gerade im E-Commerce-Bereich, eine Omni-Channel-Strategie ausgearbeitet werden, da die Suche nicht mehr linear stattfindet. Neben Google spielen hier vor allem die Sozialen Medien wie TikTok eine große Rolle. Unternehmen müssen also dafür sorgen, dass sie sowohl in der Google-Suche als auch auf Social Media gefunden werden und präsent sind. Einer der am meisten wachsenden Sparten bei Google ist übrigens YouTube – das verdeutlicht, wie wichtig Videos sind und werden.

Am Ende seines Vortrags wirft Bastian 10 provokante Thesen über die Zukunft von Technologie, Privatsphäre und Suchmaschinen auf, wobei Vertrauen, Diversität und smarte Content-Strategien entscheidend sind. Sein Fazit: Die Zukunft liegt in der Verbindung von Branding und AI – „The future is BrAInd“.

Entlang der Google Prozesskette zu besseren Analysen und Strategien (Johan von Hülsen)

Johan präsentiert in seinem Vortrag die komplexe Prozesskette von Google auf eine kreative und verständliche Weise anhand einer märchenhaften Geschichte. Die Hauptfigur Doki, ein Dokumenten-Elf, veranschaulicht, wie ein Dokument den Weg in den Google-Index und zum Ranking findet.

Der Prozess beginnt mit zwei grundlegenden Fragen:

- Kann Google unseren Content crawlen?

- Möchte Google unseren Content überhaupt crawlen?

Johan empfiehlt, URLs zu überprüfen, die zwar gecrawlt, aber nicht indexiert wurden. Besonders wenn dies mehr als 10 % der URLs betrifft, sollte man genauer hinschauen und handeln. Zur Überprüfung der Crawl-Fähigkeit rät er, die GSC Crawl Requests zu analysieren.

Anschließend folgt das Rendering, wobei Probleme wie leere Kategorieseiten oder irreführende Überschriften zu Soft 404-Fehlern führen können. Um sicherzustellen, dass der Content korrekt erkannt wird, sollte man den HTML-Code (mit deaktiviertem JavaScript) mit der Darstellung im Browser vergleichen.

Der weitere Prozess umfasst:

- Indexierung durch die „Doc-Joiner-Direktoren“

- Inverted Index: Zerlegung des Contents in einzelne Tokens

Johan empfiehlt den Ascorer-Hack zur Optimierung einzelner Rankings und erwähnt abschließend die Rolle der „Twiddler“ im Prozess.

Social Media und SEO: So nutzt du Synergien (Sara Schwartz)

Die digitale Landschaft verändert sich: Social-Media-Plattformen, wie TikTok oder YouTube, werden zunehmend als Suchmaschinen genutzt, besonders von jüngeren Nutzenden. Google passt sich an, indem Kurzvideos in den Suchergebnissen angezeigt und hervorgehoben werden.

Wichtige Punkte:

- Gezielte Verwendung von Keywords auf Social Media ist wichtig, aber die Qualität des Inhalts bleibt entscheidend.

- Social Media hilft, Trends zu erkennen und Website-Traffic zu steigern.

- Erfolgreiche Strategie ist es, Inhalte für mehrere Plattformen optimieren und den Nutzen für die Zielgruppe in den Vordergrund stellen.

- Erfolgsmessung gelingt durch A/B-Tests und Analysen des Nutzerverkehrs.

- Fazit: Social Media und SEO sollten integriert betrachtet werden, um die wertvollen Synergien zu nutzen.

Aktuelle Suchtrends und wie sie deinen SEO-Erfolg beeinflussen (Kevin Indig)

Nicht ganz unähnlich zur Keynote von Grimm waren die Take-aways aus Kevin Indigs Vortrag. Er präsentierte 5 Trends:

- Der zunehmende Einfluss von nicht-kommerziellem Content (z. B. Reddit) und die Bedeutung, sich als Marke aktiv dort einzubringen.

- Der Rückgang von Zwischenhändlern und die damit wachsende Relevanz der direkten Markenpositionierung.

- Die steigende Wichtigkeit der Seitenqualität, die kontinuierlich überwacht und optimiert werden muss.

- Googles Entwicklung hin zu einem Suchmarktplatz, was Produktseiten und das Google Merchant Center unverzichtbar für SEOs macht.

- Die Rolle der AI-gestützten Suche, bei der zukünftig vor allem Engagement-Metriken entscheidend sein werden

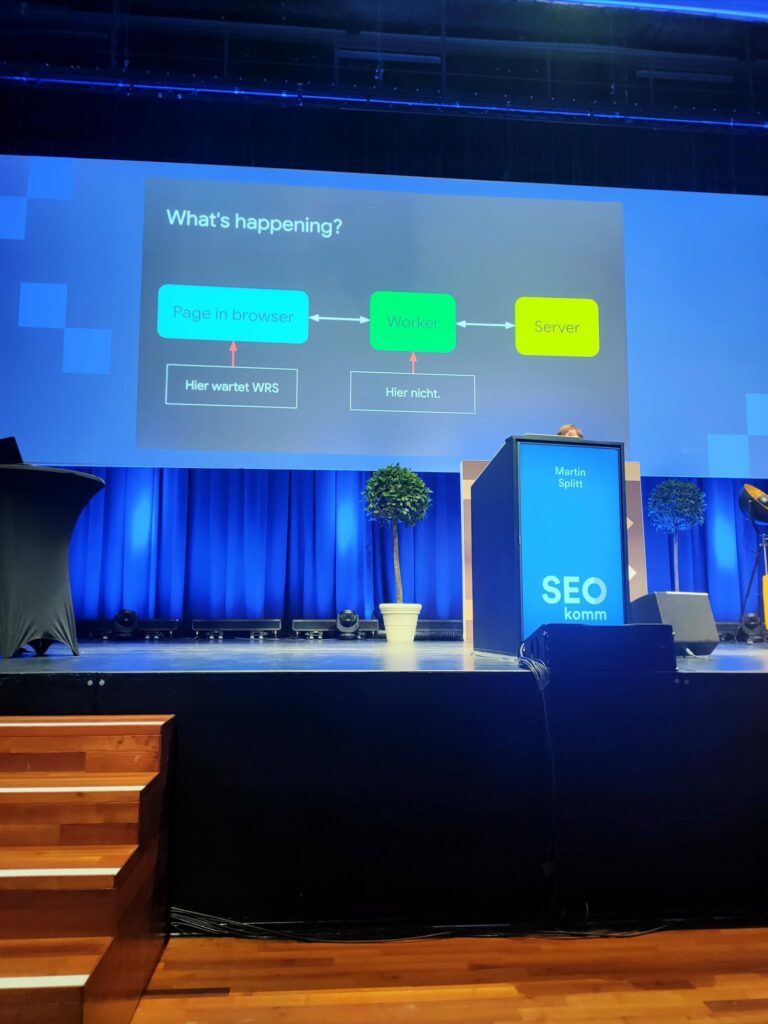

Fehler über Fehler – wie behebe ich technische Probleme? (Martin Splitt)

Martin Splitt beleuchtete in seinem Vortrag die Komplexität technischer SEO-Probleme und deren Lösungsansätze. Er machte deutlich, dass viele SEO-Probleme oft über die sichtbare Anwendungsebene hinausgehen und sich bis in die Server- und Netzwerkebene erstrecken. Diese Verschachtelung macht es besonders schwierig, Probleme zu erkennen und zu beheben.

Ein Schwerpunkt des Vortrags lag auf der Funktionsweise von Browsern und den Gründen für nicht-indexierte Seiten. Splitt erklärte beispielsweise, wie XHR-Anfragen zu solchen Problemen führen können. Er unterstrich zudem die Bedeutung eines umfassenden Verständnisses der eigenen Netzwerkinfrastruktur. Komponenten wie CDNs, Firewalls, Proxies und Gateways können ebenso Fehlerquellen darstellen wie DNS, TCP/IP oder HTTP.

Splitts praktischer Ratschlag lautete: Halte den Code so schlank wie möglich, aber so umfangreich wie nötig. Er empfahl den Einsatz verschiedener Tools zur Problemidentifikation und betonte die Wichtigkeit, über den Tellerrand zu schauen, um verborgene Ursachen aufzuspüren. Laut Splitt kann ein systematischer Blick auf alle technischen Ebenen oft den entscheidenden Durchbruch bei der Lösung von SEO-Problemen bringen.

Martin Splitt räumt ein, dass es auch bei Google manchmal zu Fehlern kommen kann. Wie zum Beispiel eine Funktion, die für Redirects gedacht war, aber auch ausgeführt wurde, wenn es keinen Redirect gab. So kam es dazu, dass eine Seite fälschlicherweise nicht indexiert wurde.

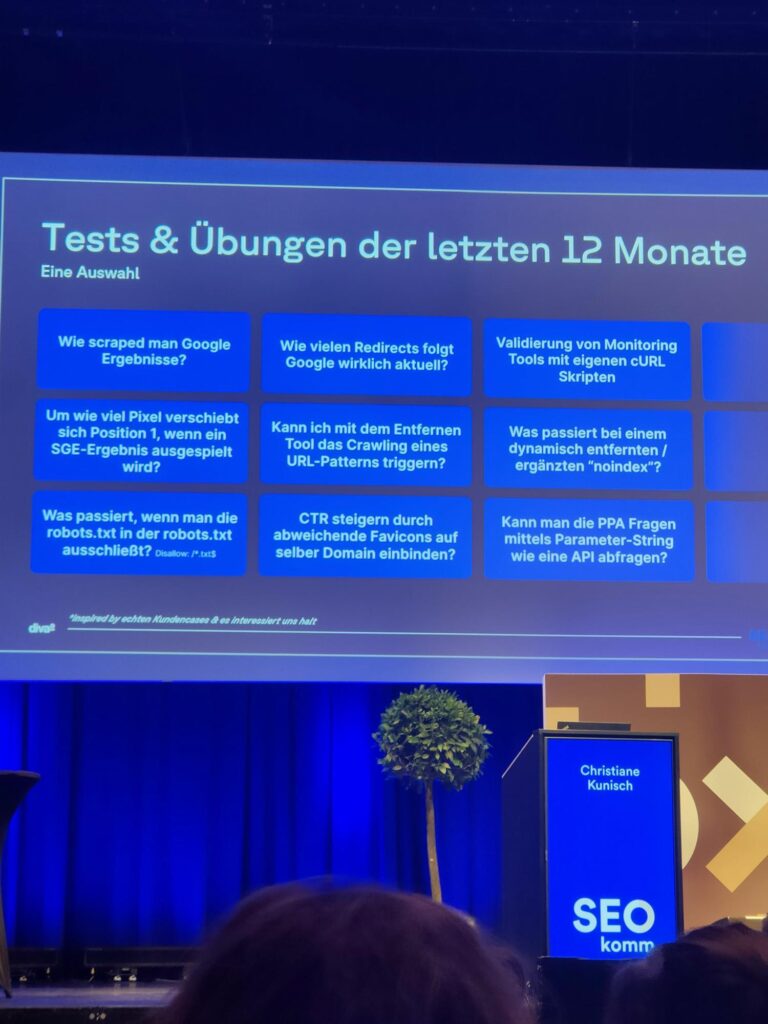

Better safe than sorry – die Macht des Testens im technischen SEO (Christiane Kunisch)

Chrissy erzählte in ihrem Vortrag von ihrer Geheimwaffe gegen das Impostor-Syndrom: Testing. Lebhaft und anschaulich zeigte sie, wie sie vorgeht, wenn ihr Fragen begegnen, auf die sie zwar eine Antwort vermutet, sie aber nicht weiß und präsentierte anschließend die Erkenntnisse ihrer letzten Tests:

- Alle SEO-relevanten Inhalte, die indexiert werden sollen, müssen innerhalb von 5 Sekunden nach dem Download des initialen HTML-Dokuments geladen haben.

- Bilder, die indexiert werden sollen, müssen in einem Image-Tag vorliegen. Die Bilder-Sitemap kann zusätzlich unterstützen, die Bilder zu indexieren.

- Base64-encodete Bilder werden langsamer indexiert und die Verknüpfung zum Alt-Text wird nicht (zuverlässig) hergestellt.

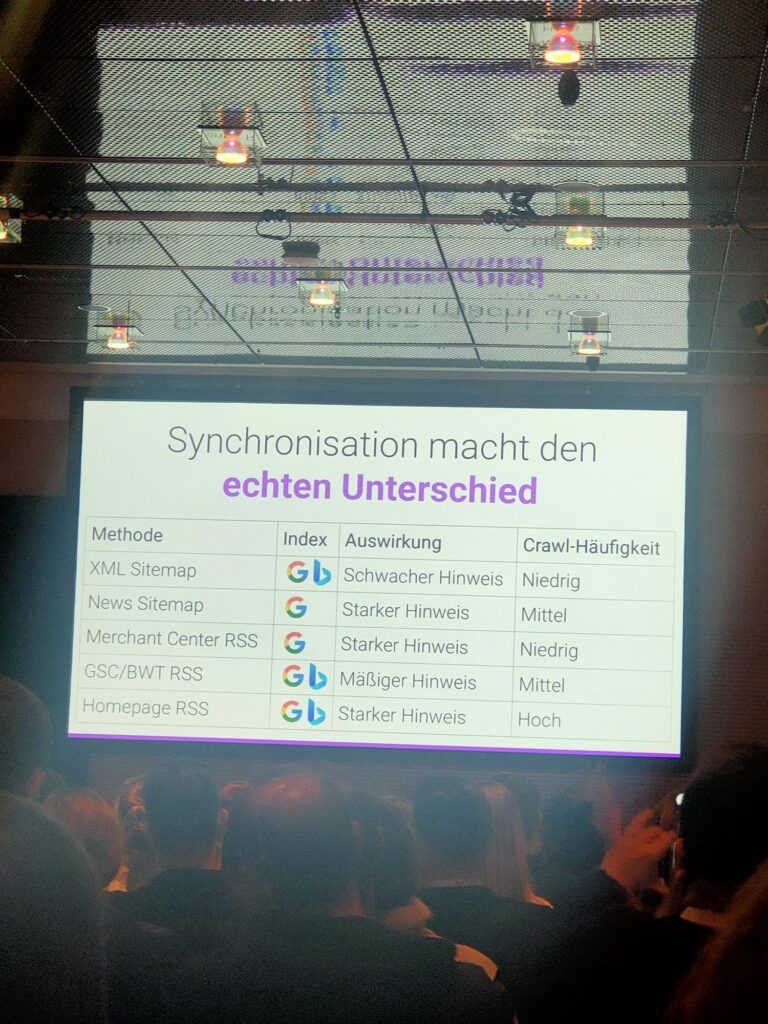

Schnelleres Crawling und Indexierung, ohne das Content-Rad neu erfinden zu müssen (Jes Scholz)

Sehr beeindruckend war Jes‘ Vortrag in vielerlei Hinsicht: Die Australierin ist extra für die SEOkomm angereist, sie hielt ihren Vortrag (zum allerersten Mal) komplett auf Deutsch und spannend war er auch noch. Auch ihr Fokus lag darauf, Empfehlungen für eine Welt mit weniger relevanten Verteilerseiten, wie Kategorieseiten, zu geben und stattdessen darauf zu achten, dass der relevantere Deep Content (also Blogartikel, Produktseiten, o. Ä.) auch wirklich zeitnah indexiert wird. Sie beschreibt, welche Tools es auf dem Markt gibt – von Google, aber auch von Bing – und wie zuverlässig diese funktionieren. Spannenderweise ist bei Google zwar die einzureichende URL-Anzahl streng limitiert, dafür funktionieren die Google-Tools (manuelle Einreichung oder Indexing API) aber zuverlässig – nicht so bei Bing. Durch den Einsatz der URL Inspection API und gezielten RSS-Feed- oder Homepage-Verlinkungen für neue URLs lässt sich allerdings die Indexierungszeit erheblich reduzieren.

Logfile-Analyse light mit der Google Search Console (Juliane Bettinga)

Auch Juliane beginnt ihren Vortrag mit dem Hinweis darauf, wie wichtig es ist, Ressourcen effizient zu nutzen und somit das Crawling effizienter zu gestalten. Dazu eignet sich am besten eine Logfile-Analyse. Oftmals hapert es da aber schon an der Datenbeschaffung oder -verarbeitung. Deshalb stellt Juliane einen Prozess einer Light-Logfile-Analyse mithilfe der GSC vor.

E-Commerce SERP-Beben: Ableitungen für erfolgreiche SEO-Strategien in 2025? (Stefan Vorwerk)

Vorwerk betonte den zunehmenden Einfluss von AI Overviews und Product Grids und empfahl SEOs, sich an den Entwicklungen in den USA zu orientieren. In den USA werden die Product Grids bei transaktionalen Keywords in 50 % der Fälle schon angezeigt. Zudem sei eine Zunahme der Diversität in den SERPs zu beobachten, mit mehr Beratungs- und Markenelementen wie z. B. Videos. Weitere Take-aways:

- Der Preis ist ein entscheidender Faktor für die Gewinnung von Klicks, gefolgt von Faktoren wie Rückgabemöglichkeiten.

- Vorwerk unterstrich die Notwendigkeit der Zusammenarbeit zwischen SEO und den verantwortlichen Abteilungen, um wettbewerbsfähig zu bleiben.

- Produktbeschreibungen sollten Priorität haben.

- Zugang zum Merchant Center ist wichtig, da Feed-Inhalte wichtiger als Product Grids sind.

- Die Kaufentscheidung sollte durch gute Bilder unterstützt werden.

- Der Titel ist das wichtigste Element, um die Klickrate auf ein Listing zu erhöhen.

- Alle möglichen Attribute (Mark-Ups) sollten genutzt werden, um die Sichtbarkeit zu steigern.

- Eine gute Ladezeit ist wichtig.

- Kategorieseiten sind immer noch Traffic-Treiber (zumindest in Deutschland) und haben im Vergleich zu 2023 kaum an Bedeutung verloren.

SEO einfach einfach: Durch Lösungs- statt Problemorientierung zum Erfolg (Stephan Czysch)

In seinem Vortrag plädierte Stefan Czysch für eine vereinfachte und lösungsorientierte Herangehensweise im SEO. Oft scheitert es schon an den Basics. Die Erfolgsfaktoren im SEO sind bekannt, werden nur nicht umgesetzt.

- Laut Czysch sollte immer das “Warum?” der Startpunkt einer SEO-Strategie sein.

- Seiten, die keinen Traffic generieren, sollten kritisch hinterfragt werden; sind diese relevant für mein Business und zahlen auf das Unternehmensziel ein oder sind sie verzichtbar?

- Des Weiteren gab er einige Ansätze, was SEOs seiner Meinung nach tun sollten:

- Traffic-Anteil der Top-Seiten erheben und diese Seiten pflegen

- Sich fragen, ob sie den Traffic bekommen, den sie möchten

- Prioritäten definieren und mit Zielseiten zusammenbringen

Expertenstatus im Netz dank KI? E-E-A-T-Check von ChatGPT-Content (Beatrice Eiring)

Beatrice erstellte mit ihrem Team KI-Texte im Bereich Finanzen und Medizin. Anschließend ließ sie diese Texte von ausgewiesenen Expert:innen (Ärzt:innen und Finanzexpert:innen) kontrollieren und forderte Feedback ein:

- KI-Texte schneiden beim E-E-A-T-Check nicht schlecht ab, sind aber nicht perfekt.

- Vor allem bei YMYL-Themen (Your Money Your Life) zeigen sich Schwächen.

- Medizinische KI-Texte erfassen oft wichtige Punkte, aber nicht immer korrekt.

- Finanztexte von KI sind oft pauschalisiert und bieten keinen Mehrwert.

- KI-Texte können gute Rankings erzielen, obwohl sie Fehler enthalten.

- Google scheint bei KI-Texten aktuell nicht so genau hinzusehen.

- KI kann zur effizienten Content-Erstellung beitragen, aber der Expertenstatus kann nicht allein durch KI erreicht werden.

- Die Kombination aus KI und menschlichem Know-how ist der Schlüssel zum Erfolg.

Das Beste kommt zum Schluss 😉

Am besten fanden wir natürlich – ganz unvoreingenommen – die Vorträge von Nadine und Kevin. Während Kevin wieder einmal in seinem Element war und anderen AI-Begeisterten praktische Tipps und Anwendungsfälle für KI in einem Deep Dive mit ihnen teilte, gab es von Nadine eine Einführung in die neuesten Screaming Frog-Updates.

Deep Dive: Automatisierter und intelligenter KI-Einsatz für mehr SEO-Effizienz (Kevin Kirchhoff)

# SEO-Automatisierung und KI-Strategien: Revolutionierung digitaler Workflows

In der sich rasant entwickelnden digitalen Welt präsentierte Kevin einen wegweisenden Ansatz zur Transformation von SEO-Prozessen durch Technologien wie Vector Embeddings, Automatisierung und KI-Agents. Der Kern seiner Botschaft: Repetitive Aufgaben müssen nicht länger manuelle Ressourcen binden, sondern können intelligent und effizient gestaltet werden.

Vector Embeddings bilden dabei die technologische Grundlage für semantische Datenanalyse. Diese numerischen Darstellungen ermöglichen es, komplexe Informationen in mehrdimensionalen Räumen zu verarbeiten und Ähnlichkeiten zu erkennen. In der Praxis bedeutet dies beispielsweise, dass beim Redirect Mapping für einen E-Commerce-Shop mit 190.000 URLs der Prozess von manueller Arbeit auf eine KI-gestützte Lösung umgestellt werden kann – mit über 99 % Zeitersparnis.

Die Ähnlichkeitssuche mittels Cosine Similarity und Clustering-Techniken wie K-Means oder DBSCAN eröffnet völlig neue Analysemöglichkeiten. Unternehmen können nun Keyword-Clustern semantisch zusammenhängende Inhalte zuordnen, Produktkategorien intelligent strukturieren und die interne Verlinkung optimieren. Diese Methoden gehen weit über traditionelle SEO-Ansätze hinaus und ermöglichen eine deutlich tiefere, datengetriebene Content-Strategie.

SEO-Automatisierung ist mehr als nur ein Buzzword – sie ist eine Notwendigkeit für moderne Marketingteams. Kevin demonstrierte dies am Beispiel eines Content Audits, das die Arbeitskosten um sagenhafte 97 % reduzieren kann. Durch den Einsatz von Tools wie Make.com, KNIME und Python lassen sich komplexe Datenflüsse automatisieren, Crawling-Prozesse optimieren und Ergebnisse präzise aufbereiten.

Ein konkretes Praxisbeispiel ist der automatisierte KI-Newsletter: In zehn systematischen Schritten werden RSS-Feeds abgerufen, Daten formatiert, durch KI-Systeme analysiert und als Newsletter versendet. Dieser Workflow zeigt exemplarisch, wie moderne Technologien manuelle Prozesse nahezu vollständig ersetzen können.

Die nächste Evolutionsstufe bilden AI Agents: autonome KI-Systeme mit eigener Entscheidungsfähigkeit. Anders als herkömmliche KI-Assistenten können diese mehrschrittige Aufgaben selbstständig planen und ausführen. Implementierungen über Frameworks wie Flowise, n8n oder Langchain ermöglichen Anwendungen von eigenen Chatbots bis hin zu komplexen Multi-Agent-Content-Systemen.

Eine Fallstudie aus dem B2B-Bereich untermauert die Wirksamkeit: Durch KI-gestützte Textoptimierung stiegen die Impressionen um 275 % und die Klicks um 210 %. Diese Zahlen verdeutlichen das immense Potenzial intelligenter Automatisierungsstrategien.

Kevins Empfehlung für Unternehmen lautet daher: Beginnt mit der Identifikation nerviger, repetitiver Aufgaben. Visualisiert den potenziellen Zeitgewinn, wählt passende Automatisierungstools und integriert Technologien Schritt für Schritt. Der Schlüssel liegt nicht in der sofortigen Kompletttransformation, sondern in kontinuierlichem Lernen und agilen Anpassungen.

Die Botschaft ist klar: SEO wird zunehmend von Künstlicher Intelligenz und intelligenten Automatisierungslösungen getrieben. Unternehmen, die diese Technologien früh und strategisch implementieren, werden einen signifikanten Wettbewerbsvorteil erzielen.

Die neuesten Screaming Frog-Tipps (Nadine McNulty)

Angekündigt wurde Nadine damit, dass sie von einer „unfassbar coole[n] SEO und Content Marketing Agentur aus Berlin“ kommt – das können wir natürlich nur bestätigen. 😉

Nadine zeigte die neusten Screaming Frog-Updates und wie es gelingt, SEO-Analysen z. B. durch die Integration von AI APIs noch effizienter zu gestalten.

OpenAI-Prompts nutzen

Die Integration von OpenAI in Screaming Frog ermöglicht die Automatisierung komplexer Aufgaben wie Intent-Analysen, Textzusammenfassungen oder das Erstellen von Alt-Tags für Bilder. Die Konfiguration erfolgt direkt im Tool, ohne dass JavaScript-Kenntnisse erforderlich sind.

- Einmalige Einrichtung des API-Keys

- Auswahl vordefinierter oder individuell erstellter Prompts

- Export der Ergebnisse zur Weiterverarbeitung

Dank der intuitiven Bedienung können Analysen schnell und präzise durchgeführt werden.

Embeddings für tiefere Einblicke

Vector Embeddings sind numerische Darstellung, die semantische Beziehungen und Ähnlichkeiten von Content erfassen. Nadine erklärte, wie man mit einem OpenAI API Key und Screaming Frog Embeddings erstellt und diese mit einem von Claneo entwickelten Tool weiterverarbeitet.

Embeddings helfen bei folgenden SEO-Tasks:

- Erstellen thematischer Keyword-Cluster

- Identifikation von Duplicate Content

- Optimierung der internen Verlinkung

- Redirect-Mapping

Aktionen mit JavaScript Snippets

Mit Custom JavaScript Snippets lassen sich Aktionen von Screaming Frog während des Crawls ausführen. Dazu zählen unter anderem:

- Simuliertes Scrollen auf Seiten

- Erfassung dynamisch geladener Inhalte

- Automatisches Akzeptieren von Cookie-Bannern

N-Gram Analysen für Optimierung der internen Verlinkung

Die N-Gram Funktion in Screaming Frog analysiert die Häufigkeit einzelner Wörter verschiedener Längen (1-Gram, 2-Gram, 3-Gram, usw.), um Content besser zu kategorisieren. Laut Nadine eignet sich diese Funktion besonders für:

- Das Aufdecken von Keyword-Lücken

- Die Erkennung kannibalisierender Inhalte

- Die Verbesserung interner Verlinkungen

Zudem zeigte sie eine Excel-Formel, mit der sich eine Interne Verlinkungsmatrix erstellen lässt.

Segmente für präzisere Analysen

Die Segmentierung nach Seitentypen erleichtert die gezielte Analyse von Fehlern und Optimierungspotenzialen. Beispielsweise können Kategorien-, Produkt- oder Blogseiten separat betrachtet werden. Nadine zeigte, wie Segmente definiert und die Ergebnisse effizient ausgewertet werden können.

Bonus: Unterschiede zwischen Raw-HTML und Rendered-HTML

Das Aktivieren des JavaScript-Renderings ermöglicht den Vergleich von Raw-HTML mit gerendertem HTML. Diese Funktion ist besonders hilfreich bei der Analyse dynamischer Websites, da so Unterschiede im initialen HTML und sichtbaren Content sichtbar gemacht werden.

Unser Fazit

Die SEOkomm 2024 hat eindrucksvoll gezeigt, dass SEO ein dynamisches und sich ständig weiterentwickelndes Feld bleibt. Expert:innen betonten die wachsende Bedeutung von Produktseiten, Markenbildung und Omni-Channel-Strategien. Technische Optimierungen, Content-Qualität, E-E-A-T und Barrierefreiheit blieben wichtige Schwerpunkte. Vorträge zur Automatisierung und KI-Integration zeigten neue Wege zur Effizienzsteigerung. Die Konferenz bot hochkarätigen Wissensaustausch und exzellente Networking-Möglichkeiten. Sie unterstrich die Notwendigkeit für SEO-Profis, innovativ zu bleiben und gleichzeitig bewährte Praktiken zu pflegen.