Guide

Technisches SEO für Websites

Technisches SEO (engl. technical SEO) ist ein unverzichtbarer Teil der Optimierung einer Website für Suchmaschinen wie Google. Es befasst sich mit der Seite unter der Oberfläche, einschließlich der Struktur, um sicherzustellen, dass Suchmaschinen sie effizient crawlen und indizieren können. Durch technische SEO–Maßnahmen wird der Inhalt für Nutzer und Suchmaschinen besser zugänglich und die Seite kann in den Suchergebnissen höher eingestuft werden. Eine strukturierte Herangehensweise an technisches SEO ist entscheidend für den Erfolg Ihrer Website im digitalen Ranking und sollte stets gepflegt werden, um den aktuellen Standards gerecht zu werden.

Einführung in technisches SEO

Technisches SEO (engl. technical SEO) ist die Grundlage jeder erfolgreichen Online-Präsenz. Es bezieht sich auf alle Maßnahmen, die darauf abzielen, die Crawling– und Indexierungskapazitäten einer Website durch Suchmaschinen wie Google zu optimieren. Ziel ist es, die technische Infrastruktur so zu gestalten, dass sie die Anforderungen der modernen Suchumgebung erfüllt. Dazu gehört die Optimierung der URL-Struktur, die Verbesserung der Ladegeschwindigkeit und die Sicherstellung der Mobilfreundlichkeit. Jedes dieser Elemente trägt dazu bei, dass die Seite effizienter gecrawlt und indiziert wird.

Inhaltsverzeichnis

ToggleEin wesentlicher Bestandteil von technischem SEO ist die Sicherstellung, dass der Inhalt der Seite für Nutzer schnell zugänglich ist, um die bestmögliche Benutzererfahrung zu bieten. Die Verwendung von SSL-Zertifikaten sichert die Verbindung und fördert somit das Vertrauen der Nutzer. Darüber hinaus steigert eine gute technische Struktur die Chancen, dass die Seite in den Suchergebnissen auftaucht, und bietet eine solide Basis für alle weiteren SEO-Bemühungen.

Zur Unterstützung der Umsetzung gibt es zahlreiche Tools, die eine Analyse der technischen Aspekte einer Website ermöglichen. Diese Tools liefern wertvolle Informationen über die Crawlbarkeit, Indexierung und Sicherheitsstandards der Website. Indem man diese Bereiche kontinuierlich bewertet und Verbesserungen umsetzt, kann die Website ihre Sichtbarkeit und ihr Ranking in der digitalen Landschaft erheblich verbessern.

Definition und Zielsetzung

Technisches SEO bezeichnet Maßnahmen, die die technische Infrastruktur einer Website verbessern, um ihre Auffindbarkeit in Suchmaschinen zu erhöhen. Im Gegensatz zu inhaltsfokussierten SEO-Strategien konzentriert sich technisches SEO auf die Schaffung einer robusten Website-Architektur, die Crawling und Indexierung durch Suchmaschinen wie Google erleichtert. Ziel ist es, durch optimierte technische Rahmenbedingungen die Sichtbarkeit und Performance der Seite in den organischen Suchergebnissen zu steigern.

Eine der Hauptaufgaben im technischen SEO ist die Sicherstellung, dass Suchmaschinen Zugriff auf die Inhalte haben, die den Nutzern bereitgestellt werden. Dazu gehört die Optimierung der URL-Struktur, die Implementierung von Sitemaps und die korrekte Verwendung von robots.txt-Dateien. Ebenso wichtig ist die Vermeidung von Duplicate Content und die Verwendung von Canonical Tags.

Technisches SEO ist keine einmalige Maßnahme, sondern ein fortlaufender Prozess, bei dem es darum geht, stets auf dem neusten Stand der technischen Entwicklungen zu bleiben. Indem man kontinuierlich die Analyse der Website vorantreibt, können neue Optimierungsmöglichkeiten identifiziert und umgesetzt werden. So wird die Seite für Suchmaschinen und Nutzer gleichermaßen ansprechend gestaltet, was letztendlich zu einem besseren Ranking in den Suchergebnissen führt.

Wichtige Komponenten

Technisches SEO besteht aus mehreren Schlüsselkomponenten, die entscheidend sind, um die Sichtbarkeit einer Website in Suchmaschinen wie Google zu verbessern. Eine der wichtigsten Komponenten ist die URL-Struktur. Eine klare und logische URL-Struktur hilft Suchmaschinen, die Relevanz und den Inhalt einer Seite besser zu verstehen. Dazu gehört auch die Optimierung der internen Verlinkung, die den Crawling-Prozess unterstützt.

Ein weiteres zentrales Element ist die Crawlbarkeit und die Indexierbarkeit der Seite. Hierbei spielen robots.txt-Dateien eine wichtige Rolle, indem sie Suchmaschinen mitteilen, welche Teile der Websitegecrawlt werden dürfen und welche nicht. Ebenso wichtig sind XML-Sitemaps, durch die Suchmaschinen die Struktur der Website besser erfassen können.

Die Ladegeschwindigkeit ist eine weitere entscheidende Komponente. Eine schnell ladende Seite verbessert nicht nur das Nutzererlebnis, sondern auch das Ranking in den Suchergebnissen. Dazu gehört die Optimierung von Bildern und die Minimierung von CSS und JavaScript.

Schließlich muss auch die mobile Optimierung berücksichtigt werden, insbesondere in Anbetracht von Googles mobile-first-Indexierung. Ein responsives Design stellt sicher, dass die Website auf allen Geräten optimal dargestellt wird.

Website-Struktur und URLs

Die Struktur einer Website und die Gestaltung ihrer URLs spielen eine entscheidende Rolle im technischen SEO. Eine gut organisierte Website-Struktur erleichtert es Suchmaschinen, den Inhalt effizient zu crawlen und zu indexieren. Eine logische Struktur unterstützt nicht nur die Suchmaschine, sondern verbessert auch die Benutzererfahrung, indem sie Nutzer intuitiv durch den Inhalt navigieren lässt. Eine saubere und konsistente URL-Struktur ist essenziell, um die Relevanz und Hierarchie der Seite klar darzustellen.

Eine gute URL sollte klar, prägnant und lesbar sein. Sie sollte idealerweise relevante Schlüsselwörter enthalten, die den Inhalt der Seite reflektieren und das Ranking in Suchmaschinen wie Google unterstützen. Vermeiden Sie dabei unnötige Parameter und komplexe Strukturen, die sowohl Suchmaschinen als auch Nutzer verwirren könnten.

Ein effektives internes Verlinkungssystem ist ebenfalls essenziell. Es verteilt den „Link Juice“, verbessert die Crawlbarkeit und ermöglicht es, die Wichtigkeit einzelner Seiten hervorzuheben. Durch eine vernetzte Website-Struktur wird gewährleistet, dass alle relevanten Inhalte von Suchmaschinen erfasst werden und den Nutzern ein logisches und angenehmes Navigationserlebnis bieten.

Insgesamt sollte die Struktur der Website so gestaltet sein, dass sie sowohl die Suchmaschinen als auch die Nutzer anspricht und klare Informationen liefert.

Optimierung der URL-Struktur

Die Optimierung der URL-Struktur ist ein wesentlicher Bestandteil des technischen SEO. Eine durchdachte URL-Struktur kann erheblich zum besseren Ranking einer Website in Suchmaschinen wie Google beitragen. Eine optimal gestaltete URL sollte klar, prägnant und leicht verständlich sein, sowohl für Suchmaschinen als auch für Nutzer.

Beginnen Sie damit, die URLs mit relevanten Schlüsselwörtern zu versehen, die den Inhalt der Seite widerspiegeln. Vermeiden Sie unnötige Zahlen und unverständliche Zeichenfolgen, die die Lesbarkeit beeinträchtigen könnten. Eine logische und konsistente URL-Struktur erleichtert es den Suchmaschinen, die Hierarchie und den Kontext der Website zu erkennen.

Verwenden Sie Bindestriche anstelle von Unterstrichen, um Wörter in Ihrer URL zu trennen. Dies erhöht die Lesbarkeit und Suchmaschinen können die Begriffe besser interpretieren. Vermeiden Sie Großbuchstaben in URLs, da sie zu Problemen bei der Erkennung führen können.

Vorher-Nachher: Optimierte URL-Struktur

Vor der Optimierung

https://example.com/p=123?category=seo&article=technical-guide

Nach der Optimierung

https://example.com/seo/technical-guide/

Abschließend sollten Sie sicherstellen, dass die URL-Struktur durchgehend konsistent ist. Dies bedeutet, dass aus struktureller Sicht einerseits die URLs eines ähnlichen Typs auf derselben Hierarchieebene liegen, andererseits die Nutzer sich durch klare und verständliche Pfade bewegen können. Eine durchdachte URL-Struktur ist entscheidend für die erfolgreiche Crawling und Indexierung der Website durch Suchmaschinen.

Interne Verlinkung

Die interne Verlinkung ist ein essenzieller Faktor im technischen SEO, der oft übersehen wird. Sie spielt eine zentrale Rolle dabei, wie Suchmaschinen und Nutzer eine Website navigieren und ihren Inhalt verstehen. Eine gut durchdachte interne Verlinkungsstruktur verbessert die Crawlbarkeit und die Indexierung der Seite durch Suchmaschinen wie Google.

Durch interne Links können Sie die Hierarchie und die Priorität des Inhalts auf Ihrer Website festlegen. Wichtige Seiten sollten mehr Verlinkungen erhalten, um ihre Bedeutung hervorzuheben und den sogenannten „Link Juice“ effizient zu verteilen. Dies hilft Suchmaschinen, die Schlüsselseiten Ihrer Website zu erkennen und sie entsprechend höher in den Suchergebnissen zu platzieren.

Darüber hinaus verbessern gut platzierte interne Links die Benutzererfahrung, indem sie den Nutzern eine logische Navigation durch den Inhalt ermöglichen. Dadurch wird die Verweildauer auf der Website erhöht und die Absprungrate gesenkt, was wiederum positive Signale an Suchmaschinen sendet.

Achten Sie darauf, dass Ihre internen Links sinnvoll und kontextbezogen sind. Vermeiden Sie es, wahllos Links zu setzen, und stellen Sie sicher, dass jeder Link einen Mehrwert bietet und den Nutzern hilft, weiterführende Informationen zu erhalten. Eine strategisch geplante interne Verlinkung ist ein Schlüssel zu einer gut optimierten Website.

Wichtigkeit der internen Links

Interne Links sind ein wesentlicher Bestandteil jeder effektiven SEO-Strategie und tragen maßgeblich zur Optimierung der Website bei. Sie helfen nicht nur Suchmaschinen wie Google dabei, die Struktur Ihrer Website zu verstehen, sondern verbessern auch das Nutzererlebnis erheblich, indem sie den Nutzern helfen, nahtlos durch den Inhalt zu navigieren.

Ein fundamentaler Aspekt der internen Verlinkung ist ihre Rolle bei der Verteilung des „Link Juice“. Durch interne Links fließt Autorität von einer Seite zur anderen, was sich positiv auf das Ranking in den Suchergebnissen auswirkt. Wichtig ist hierbei, dass die verlinkten Seiten thematisch relevant sind, um den Nutzern wertvolle Informationen zu bieten.

Interne Links unterstützen zudem die Crawlbarkeit und Indexierung durch Suchmaschinen. Sie schaffen eine logische und zusammenhängende Struktur, die es Suchmaschinen erleichtert, den gesamten Inhalt der Website effizient zu crawlen. Dies führt zu einer umfassenderen Indizierung Ihrer Webseiten und einer besseren Sichtbarkeit in den Suchergebnissen.

Darüber hinaus fördern interne Links die Verweildauer der Nutzer auf Ihrer Website, da sie dazu ermutigt werden, sich weiter mit verwandten Inhalten zu beschäftigen. Dies sendet positive Signale an Suchmaschinen, die letztlich zu einer besseren Bewertung der Seite führen können. Insgesamt sind interne Links ein kraftvolles Werkzeug zur Verbesserung der SEO-Leistung der Website.

Best Practices für interne Links

Bei der Umsetzung einer effektiven internen Verlinkungsstrategie gibt es einige Best Practices, die beachtet werden sollten, um die Website optimal für Suchmaschinen und Nutzer gleichermaßen zu gestalten. Zunächst einmal ist die Relevanz der Links entscheidend. Stellen Sie sicher, dass die verlinkten Seiten thematisch zueinander passen und dem Nutzer wertvolle Informationen bieten.

Ein weiterer wichtiger Aspekt ist der Ankertext, also der sichtbare Text, der mit einem internen Link versehen ist. Dieser sollte beschreibend und aussagekräftig sein, sodass der Nutzer sofort versteht, worum es auf der verlinkten Seite geht. Vermeiden Sie generische Ankertexte wie „hier klicken“ und bevorzugen Sie präzisere Formulierungen.

Zudem sollten wichtige Seiten Ihrer Website mehr interne Links erhalten, um deren Bedeutung zu verdeutlichen und den Link Juice effektiver zu verteilen. Dies hilft auch den Suchmaschinen, die zentrale Rolle dieser Seiten besser zu erfassen.

Organisieren Sie die interne Verlinkung so, dass sie eine logische Struktur widerspiegelt. Eine flache Hierarchie, bei der wenige Klicks nötig sind, um jede Seite zu erreichen, fördert die Crawlbarkeit Ihrer Website und verbessert das Ranking in den Suchergebnissen. Letztlich sollten interne Links stets regelmäßig überprüft und aktualisiert werden, um sicherzustellen, dass keine toten Links existieren, die das Nutzererlebnis beeinträchtigen können.

Crawlbarkeit und Indexierbarkeit

Die Crawlbarkeit und Indexierbarkeit sind zentrale Elemente des technischen SEO, die sicherstellen, dass Suchmaschinen wie Google alle relevanten Inhalte Ihrer Website erfassen und in den Suchergebnissen anzeigen können. Eine gute Crawlbarkeit bedeutet, dass alle Seiten Ihrer Website einfach von Suchrobots erreicht werden können. Dies wird durch eine durchdachte Website-Struktur und effektive interne Verlinkung unterstützt.

Die Indexierbarkeit bezieht sich darauf, ob die von Suchmaschinen gecrawlten Seiten auch tatsächlich in den Index aufgenommen werden können. Eine korrekte Nutzung der robots.txt-Datei und der Implementierung von Meta-Tags wie „noindex“ stellt sicher, dass nur relevante Seiten indexiert werden.

Die Erstellung und Pflege von Sitemaps ist ebenfalls ein wichtiger Schritt, um die Crawlbarkeit und Indexierbarkeit zu optimieren. XML-Sitemaps geben Suchmaschinen einen strukturierten Überblick über alle verfügbaren Seiten einer Website und helfen dabei, auch weniger verlinkte Inhalte leichter zu entdecken.

Technische Analysewerkzeuge können dazu genutzt werden, um potenzielle Probleme zu identifizieren, wie z.B. Broken Links oder Seiten, die nicht indexiert werden. Durch regelmäßige Prüfungen dieser Aspekte kann die technische Gesundheit der Website gewährleistet und das Ranking in den Suchergebnissen verbessert werden. Die Sicherstellung einer guten Crawlbarkeit und Indexierbarkeit ist ein kontinuierlicher Prozess, der konstante Aufmerksamkeit erfordert, um mit den Entwicklungen im Bereich Suchmaschinen Schritt zu halten.

Die Rolle der robots.txt

Die robots.txt-Datei ist ein zentrales Element im technischen SEO, das die Crawlbarkeit einer Website steuert. Diese einfache Textdatei befindet sich im Hauptverzeichnis einer Website und dient als Kommunikationstool zwischen den Websites und den Suchmaschinen. Sie enthält Anweisungen über den Zugriff der Suchmaschinen-Crawler auf bestimmte Bereiche der Website.

Durch die richtige Konfiguration der robots.txt-Datei können Webmaster steuern, welche Seiten und Verzeichnisse von Suchmaschinengecrawlt werden dürfen und welche nicht. Dies ist besonders wichtig, um vertrauliche Daten zu schützen oder überflüssigen Inhalt von der Indexierung auszuschließen. Zum Beispiel könnten Seiten mit doppelten Inhalt oder spezifische Suchergebnis-Seiten von der Indexierung ausgeschlossen werden, um die SEO-Effizienz zu verbessern.

Es ist wichtig, die robots.txt-Datei regelmäßig zu überprüfen und zu aktualisieren, um sicherzustellen, dass die Anweisungen mit den aktuellen Zielen der Website übereinstimmen. Ein Fehler in dieser Datei kann potenziell wichtige Seiten für Suchmaschinen unsichtbar machen, was zu einem Verlust an Sichtbarkeit in den Suchergebnissen führen kann. Daher ist es entscheidend, die robots.txt sorgfältig zu gestalten und ihre Auswirkungen auf die Crawlbarkeit der Website zu verstehen.

XML-Sitemaps erstellen und pflegen

Das Erstellen und Pflegen von XML-Sitemaps ist ein wichtiger Schritt im Rahmen des technischen SEO. Eine XML-Sitemap ist im Grunde eine vollständige Liste aller wichtigen Seiten einer Website, die Suchmaschinen wie Google dabei unterstützt, den Inhalt effizienter zu crawlen und zu indexieren. Sie ist besonders nützlich für umfangreiche Websites oder solche mit einer komplexen Struktur, wo möglicherweise nicht alle Seiten leicht zugänglich sind.

Eine gut gestaltete XML-Sitemap sollte alle relevanten URLs enthalten. Dabei ist es wichtig, dass sie regelmäßig aktualisiert wird, um Änderungen oder neue Inhalte widerzuspiegeln. Diese Aktualisierungen sollten automatisch erfolgen, insbesondere wenn neue Seiten hinzugefügt oder bestehende Seiten geändert werden.

Besondere Aufmerksamkeit sollte auf die Priorisierung innerhalb der XML-Sitemap gelegt werden, um den Suchmaschinen zu signalisieren, welche Seiten von besonderer Bedeutung sind. Darüber hinaus können Sie bei der Erstellung der XML-Sitemap spezifische Metadaten wie das Datum der letzten Aktualisierung hinzufügen, um die Effizienz der Indexierung zu erhöhen.

Zahlreiche Tools stehen zur Verfügung, um die Erstellung und Verwaltung von XML-Sitemaps zu erleichtern, sodass die kontinuierliche Pflege dieser wertvollen SEO-Resource gewährleistet ist. Eine sorgfältig verwaltete XML-Sitemap trägt wesentlich zur Sichtbarkeit einer Website in den Suchergebnissen bei.

XML-Sitemap erstellen und einreichen

-

Sitemap generieren

Nutze ein Tool wie Screaming Frog oder ein CMS-Plugin, um eine XML-Sitemap zu erstellen.

-

Sitemap validieren

Überprüfe die Sitemap auf Fehler mit dem XML Sitemap Validator.

-

Sitemap hochladen

Lade die Sitemap in das Stammverzeichnis deiner Website hoch.

-

Bei Google einreichen

Reiche die Sitemap in der Google Search Console ein.

Canonical Tags und ihre Bedeutung

Canonical Tags sind ein wichtiges Instrument im technischen SEO, das hilft, Duplicate Content zu verwalten und die Indexierung zu optimieren. Sie geben Suchmaschinen wie Google klare Hinweise darauf, welche Version einer Seite als die maßgebliche angesehen werden soll, wenn mehrere URLs mit identischem oder ähnlichem Inhalt existieren.

Durch die Implementierung von Canonical Tags wird das Risiko reduziert, dass Duplicate Content sich negativ auf das Ranking Ihrer Website auswirkt. Diese Tags helfen dabei, die Autorität und den „Link Juice“ auf die bevorzugte Seite zu konzentrieren und verhindern, dass Suchmaschinen unsicher darüber sind, welche Seite sie indizieren sollen.

Die Anwendung von Canonical Tags ist besonders wichtig für E-Commerce-Websites, bei denen Produkte oft in verschiedenen Kategorien angezeigt werden, oder bei Websites mit druckfreundlichen Seiten. Bei der Einrichtung von Canonical Tags sollte darauf geachtet werden, dass sie korrekt platziert sind und auf die kanonische URL verweisen.

Regelmäßige Überprüfungen sind entscheidend, um sicherzustellen, dass alle Canonical Tags ordnungsgemäß funktionieren und keine falschen Kanonen aufweisen, die den Suchindex negativ beeinflussen könnten. Richtig verwendete Canonical Tags sind ein Schlüsselelement für eine effektive SEO-Strategie.

Vermeidung von Duplicate Content

Duplicate Content stellt eine häufige Herausforderung im Bereich des technischen SEO dar und kann das Ranking Ihrer Website negativ beeinträchtigen. Suchmaschinen wie Google bevorzugen einzigartige Inhalte und bewerten doppelte Seiten oft schlechter, da sie unklar finden, welche Seite priorisiert werden sollte.

Um Duplicate Content zu vermeiden, ist es wichtig, eine strategische und einheitliche URL-Struktur zu entwickeln. Canonical Tags sind hierbei ein wertvolles Werkzeug, um Suchmaschinen die bevorzugte Version einer Seite klar anzugeben. Indem Sie den Canonical Tag auf die ursprüngliche URL setzen, konzentrieren Sie die Indexierung auf die richtige Seite.

Ein weiteres häufiges Problem ist der Versand von Links mit unterschiedlichen Protokollen oder Hostnamen (zum Beispiel www.example.com und example.com oder http und https). Stellen Sie sicher, dass Weiterleitungen eingerichtet sind, um konsistente URLs zu gewährleisten.

Darüber hinaus sollte jeder Inhalt einzigartig und wertvoll sein, um den Nutzern und den Suchmaschinen gleichermaßen gerecht zu werden. Wenn Sie ähnliche Themen behandeln, sorgen Sie für Variation und fügen Sie zusätzliche Informationen oder Perspektiven hinzu.

Schließlich lohnt es sich, regelmäßig Analysetools zu nutzen, um doppelte Inhalte zu identifizieren und effektiv zu beheben. Durch die aktive Vermeidung von Duplicate Content stärken Sie die Sichtbarkeit und die Effizienz Ihrer Website in den Suchergebnissen.

Implementierung von Canonical Tags

Die Implementierung von Canonical Tags ist ein entscheidender Schritt zur Verbesserung der SEO-Leistung Ihrer Website. Mit einem Canonical Tag können Sie Suchmaschinen wie Google anweisen, welche URL als die maßgebliche Seite angesehen werden soll, wenn es mehrere Kopien des gleichen Inhalts gibt. Dies verhindert die negativen Auswirkungen von Duplicate Content und trägt dazu bei, dass die Suchmaschinen den „Link Juice“ effektiv auf die beabsichtigte Seite konzentrieren.

Um Canonical Tags richtig zu implementieren, müssen sie im Head-Abschnitt des HTML-Dokuments jeder Seite platziert werden, die eine alternative Variante derselben Inhalts-Thematik bietet. Der Tag sollte auf die URL des Originalinhalts verweisen. Dies ist besonders wichtig für Websites mit variantenreichen Produkten, Druckversionen von Artikeln oder mehrsprachigen Seiten.

Achten Sie darauf, dass jede Seite nur auf eine kanonische URL verweist, um Verwirrung zu vermeiden und die effektivste Indexierung durch Suchmaschinen zu fördern. Es ist zudem ratsam, die Funktionalität regelmäßig zu überprüfen, um sicherzustellen, dass die Canonical Tags korrekt arbeiten und keine fehlerhaften Verlinkungen aufweisen.

Ein systematischer Einsatz von Canonical Tags stärkt die Struktur Ihrer Website und optimiert ihre Präsenz in den Suchergebnissen.

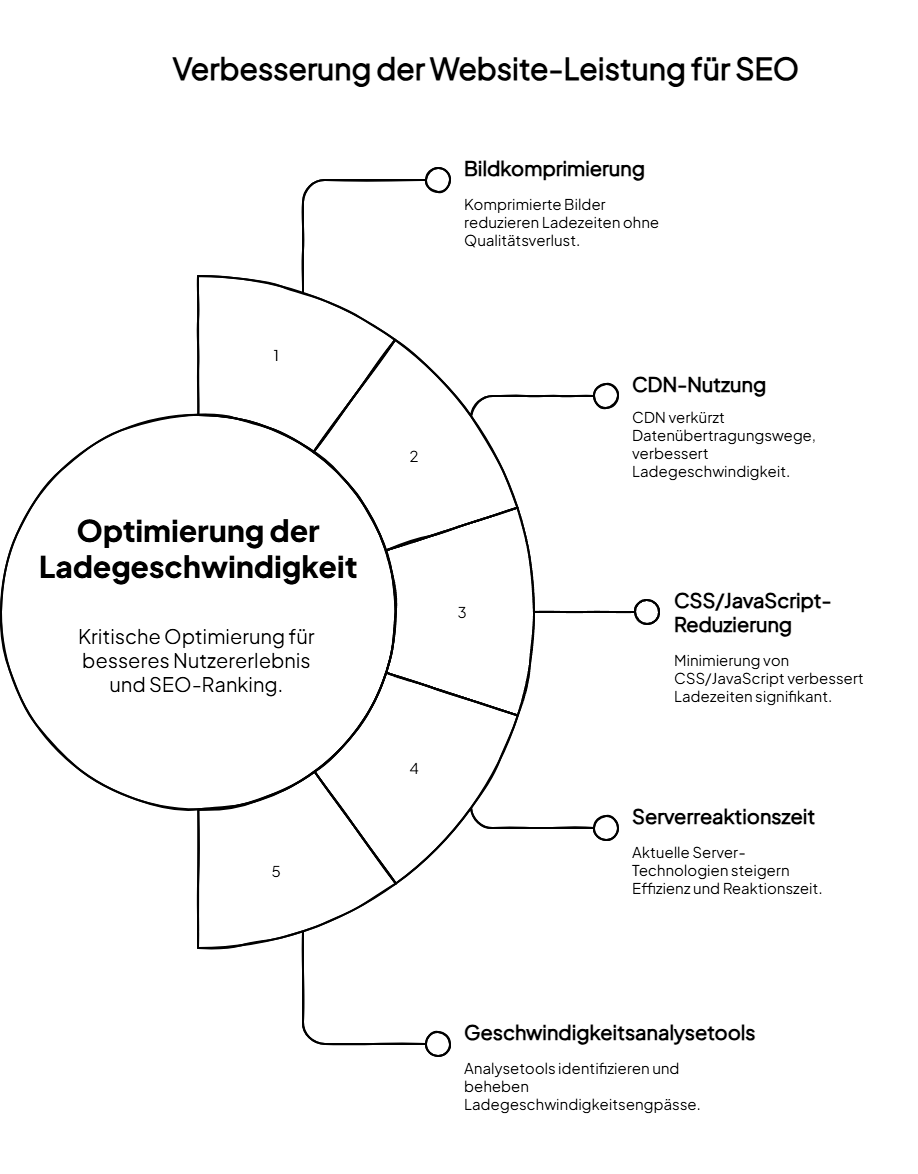

Optimierung der Ladegeschwindigkeit

Die Optimierung der Ladegeschwindigkeit ist ein kritischer Aspekt des technischen SEO, der sowohl das Nutzererlebnis als auch die Suchmaschinen–Ranking beeinflusst. Eine schnelle Website verbessert nicht nur die Benutzerzufriedenheit, sondern auch die Sichtbarkeit in Suchmaschinen wie Google, da Ladegeschwindigkeit ein wichtiger Ranking-Faktor ist.

Evolution des technischen SEO

Google gibt Ladegeschwindigkeit als Ranking-Faktor bekannt

Google bestätigt offiziell, dass die Seitenladegeschwindigkeit ein Ranking-Signal wird.

HTTPS wird zum Ranking-Faktor

Google beginnt, sichere Websites mit HTTPS in den Suchergebnissen zu bevorzugen.

Mobile-First Indexing wird eingeführt

Google stellt auf Mobile-First Indexing um, was mobile Optimierung unverzichtbar macht.

Core Web Vitals werden Teil des Ranking-Algorithmus

Nutzerfreundlichkeit und Page Experience werden zu entscheidenden Faktoren.

Um die Ladegeschwindigkeit einer Website zu optimieren, sollte mit der Minimierung von großen Bildern begonnen werden. Verwenden Sie komprimierte Formate ohne Qualitätseinbußen, um die Ladezeiten zu verkürzen. Ein weiteres effektives Mittel ist die Nutzung eines Content Delivery Networks (CDN), das Inhalte über ein Netzwerk von Servern verteilt und somit die Datenübertragungswege verkürzt.

Die Reduzierung von unnötigen CSS– und JavaScript-Dateien kann ebenfalls signifikant zur Verbesserung der Ladezeiten beitragen. Hierbei lohnt es sich, auf Minifizierung zu setzen, um die Dateigröße zu verringern, und Asynchronität oder das delayed Loading (Lazy Load) einzuführen.

Ein weiteres Augenmerk sollte auf die Serverreaktionszeit gelegt werden. Stets aktuelle Server-Technologien und Caching-Strategien verwenden, um die Effizienz der Website zu steigern.

Schließlich bietet sich die Nutzung von Tools zur Analyse der Ladegeschwindigkeit an, um potenzielle Engpässe zu identifizieren und gezielt zu verbessern. Eine optimierte Ladegeschwindigkeit stärkt nicht nur die Performance der Website, sondern sorgt auch für bessere Suchmaschinen–Rankings und eine erhöhte Nutzerzufriedenheit.

Tools zur Messung der Page Speed

Die Messung der Ladegeschwindigkeit ist entscheidend, um die Performance einer Website zu verbessern. Verschiedene Tools stehen zur Verfügung, um die Page Speed effektiv zu analysieren und potenzielle Schwachstellen aufzudecken. Eines der bekanntesten Tools ist Google PageSpeed Insights. Dieses Tool bietet detaillierte Berichte zur Ladegeschwindigkeit sowohl auf Mobilgeräten als auch auf Desktop-Computern und gibt klare Empfehlungen zur Optimierung.

Ein weiteres nützliches Tool ist GTmetrix, das umfassende Einblicke in die Website-Performance bietet, einschließlich einer detaillierten Analyse der Ladezeiten und Möglichkeiten zur Verbesserung. YSlow, ein weiteres beliebtes Tool, bewertet die Seite basierend auf den besten Praktiken von Yahoo und bietet spezifische Vorschläge zur Steigerung der Performance.

Pingdom ist ebenfalls ein unverzichtbares Tool zur Überwachung der Website-Geschwindigkeit, das Echtzeitdaten und historische Leistungsberichte liefert.

Diese Analysetools helfen nicht nur dabei, die aktuelle Performance der Seite zu verstehen, sondern liefern auch umsetzbare Empfehlungen zur Verbesserung. Durch regelmäßige Messungen und Anpassungen kann die Ladegeschwindigkeit kontinuierlich optimiert werden, was zu einer besseren Benutzererfahrung und einem höheren Ranking in den Suchergebnissen führt.

Methoden zur Verbesserung der Geschwindigkeit

Die Optimierung der Ladegeschwindigkeit ist entscheidend, um die Performance einer Website zu steigern und das Nutzererlebnis zu verbessern. Eine der effektivsten Methoden ist die Komprimierung von Bildern. Durch den Einsatz von Tools zur Bildkompression können Bilder ohne wesentliche Qualitätsverluste erheblich verkleinert werden, was die Ladezeiten reduziert.

Ein weiterer Ansatz ist das Caching. Durch die Implementierung von Browser-Caching kann eine Website häufig besuchte Inhalte lokal auf dem Gerät des Nutzers speichern, was zukünftige Ladezeiten verkürzt. Serverseitiges Caching trägt ebenfalls zur Beschleunigung bei, indem es dynamisch generierte Seiten als statische Seiten speichert.

Die Reduzierung von HTTP-Anfragen ist eine weitere Methode, um die Seitenladezeit zu verringern. Dies kann durch das Zusammenfassen von CSS und JavaScript-Dateien erreicht werden. Ebenso fördert das Entfernen nicht verwendeter CSS– und JavaScript-Code-Bestandteile eine schnellere Ladezeit.

Die Implementierung eines Content Delivery Networks (CDN) unterstützt die Verteilung von Inhalten über mehrere geografisch verteilte Server, wodurch die Ladegeschwindigkeit für Nutzer weltweit verbessert wird.

CDN für tech SEO: Vor- und Nachteile

Vorteile

- Verbesserte Ladegeschwindigkeit weltweit

- Reduzierte Serverbelastung

- Besserer Schutz vor DDoS-Angriffen

- Optimierte Bildauslieferung

- Automatische Komprimierung von Assets

Nachteile

- Zusätzliche Kosten

- Komplexere Einrichtung

- Potenzielle Caching-Probleme

- Abhängigkeit von Drittanbietern

Minifizierung von CSS, JavaScript und HTML reduziert die Größe der Dateien, die geladen werden müssen, und beschleunigt den Seitenaufbau. Durch den Einsatz dieser optimierenden Maßnahmen wird nicht nur die Performance der Website signifikant gesteigert, sondern auch das Ranking in Suchmaschinen wie Google verbessert.

Bilder optimieren

Die Optimierung von Bildern ist ein wesentlicher Schritt zur Steigerung der Ladegeschwindigkeit und der Performance einer Website. Bilder nehmen oft den größten Teil der Datenmenge einer Seite ein, und unoptimierte Bilder können die Ladezeiten erheblich verlängern, was sich negativ auf das Nutzererlebnis auswirkt und zu einem niedrigeren Ranking in Suchmaschinen wie Google führen kann.

Ein effektiver Ansatz ist die Verwendung von Bildkomprimierungstools, die die Dateigröße verringern, ohne die visuelle Qualität wesentlich zu beeinträchtigen. Formate wie WebP bieten eine bessere Kompression als herkömmliche Formate wie JPEG oder PNG und sollten, wenn möglich, eingesetzt werden.

Zusätzlich zur Komprimierung sollten Bilder in den richtigen Abmessungen hochgeladen werden, die für die Website erforderlich sind, um Skalierungsprobleme zu vermeiden. Durch die Angabe der Bildabmessungen im HTML- oder CSS-Code kann der Browser den Seitenaufbau besser optimieren.

Lazy Loading ist eine Technik, die das Laden von Bildern erst dann initiiert, wenn sie in den sichtbaren Bereich des Nutzers gelangen. Dies reduziert die initiale Ladezeit einer Seite und verbessert die Gesamtleistung der Website.

Mit diesen Optimierungsmethoden wird die Ladegeschwindigkeit erheblich verbessert, was nicht nur das Nutzererlebnis enhält, sondern auch positive Auswirkungen auf die Suchmaschinenoptimierung hat und die Sichtbarkeit der Seite in den Suchergebnissen steigert.

Minimierung von CSS und JavaScript

Die Minimierung von CSS und JavaScript ist eine effiziente Methode, die Ladegeschwindigkeit einer Website zu verbessern und die SEO-Performance zu optimieren. Durch die Reduzierung der Dateigröße und die Eliminierung unnötiger Codezeilen können Webseiten schneller geladen werden, was sowohl für die Nutzer als auch für die Suchmaschinen vorteilhaft ist.

Minifizierung umfasst den Prozess, alle unnötigen Zeichen aus CSS und JavaScript-Dateien zu entfernen, ohne ihre Funktionalität zu beeinträchtigen. Dazu gehören Leerzeichen, Zeilenumbrüche und Kommentare, die für den Browser nicht notwendig sind. Tools wie UglifyJS oder CSSNano können verwendet werden, um Dateien automatisch zu minifizieren.

Zusätzlich zur Minifizierung sollte der Umfang der verwendeten Skripte reduziert werden. Überprüfen Sie regelmäßig den Code auf ungenutzte Funktionen oder Stile und entfernen Sie diese, um die Effizienz zu maximieren.

Das Asynchrone Laden von JavaScript kann ebenfalls dazu beitragen, die Render-Zeit der Seite zu verkürzen. Dieses Vorgehen erlaubt es dem Browser, andere Inhalte der Website zu laden, während die Skripte parallel verarbeitet werden.

Durch die bewusste Minimierung und Optimierung von CSS und JavaScript wird die Ladegeschwindigkeit signifikant gesteigert, was zu einem optimierten Nutzererlebnis und besseren Suchmaschinen-Rankings führt.

Mobile Optimierung

Die Mobile Optimierung ist heutzutage ein unverzichtbarer Aspekt des technischen SEO, da immer mehr Nutzer über mobile Geräte auf das Internet zugreifen. Suchmaschinen wie Google haben Mobile-Friendliness zu einem wichtigen Ranking-Faktor gemacht, was bedeutet, dass Websites für mobile Ansichten gut optimiert sein müssen, um in den Suchergebnissen zu bestehen.

Ein zentrales Element der mobilen Optimierung ist das Responsive Design. Dieses Design passt das Layout der Website dynamisch an die verschiedenen Bildschirmgrößen von Smartphones und Tablets an. Dadurch wird sichergestellt, dass der Inhalt auf allen Geräten leicht lesbar und nutzbar ist.

Die Verbesserung der Ladegeschwindigkeit ist besonders für mobile Nutzer wichtig, da sie oft langsamere Verbindungen verwenden. Techniken wie die Optimierung von Bildern, die Minifizierung von CSS und JavaScript sowie die Nutzung von AMP (Accelerated Mobile Pages) können die mobile Performance erheblich verbessern.

Darüber hinaus sollte die Navigation vereinfacht werden, sodass Nutzer schnell auf die gewünschten Informationen zugreifen können. Berührungselemente sollten groß genug und gut platziert sein, um eine einfache Handhabung auf Touchscreens zu gewährleisten.

Durch die konsequente Umsetzung mobiler Optimierungsstrategien wird nicht nur die Benutzerfreundlichkeit verbessert, sondern auch die Sichtbarkeit der Website in den mobilen Suchergebnissen gestärkt.

Mobile First Indexing und seine Bedeutung

Mobile First Indexing ist eine bedeutende Änderung in der Art und Weise, wie Suchmaschinen wie GoogleWebseiten crawlen und indexieren. Ursprünglich nutzten Suchmaschinen die Desktop-Version einer Website, um den Inhalt und die Relevanz für Suchergebnisse zu bewerten. Mit Mobile First Indexing steht nun die mobile Version im Vordergrund. Diese Änderung spiegelt die steigende Anzahl von Nutzern wider, die über mobile Geräte auf das Internet zugreifen.

Die Bedeutung von Mobile First Indexing liegt darin, dass Websites, die nicht für mobile Endgeräte optimiert sind, Gefahr laufen, in den Suchergebnissen schlechter platziert zu werden. Eine mobile-optimierte Website verbessert das Ranking und sorgt für ein besseres Nutzererlebnis auf kleineren Bildschirmen.

Um von Mobile First Indexing zu profitieren, sollte eine Website responsive sein und sicherstellen, dass der gesamteInhalt für mobile Nutzer zugänglich ist. Darüber hinaus sollten Inhalte und Ressourcen auf der mobilen Version konsistent mit der Desktop-Version sein, um die Relevanz und Vollständigkeit zu gewährleisten.

Die Ladezeiten auf mobilen Geräten sollten durch Techniken wie Bildoptimierung und Caching verkürzt werden. Schließlich ist die User Experience durch eine einfache Navigation und gut sichtbare Interaktionselemente zu optimieren. Mobile First Indexing unterstreicht die Notwendigkeit, mobile SEO ernsthaft zu berücksichtigen, um in der digitalen Landschaft wettbewerbsfähig zu bleiben.

Responsive Design sicherstellen

Das Sicherstellen eines Responsive Designs ist essentiell für die effektive mobile Optimierung einer Website. Ein Responsive Design ermöglicht es, dass sich das Layout und die Inhalte einer Webseite dynamisch an verschiedene Bildschirmgrößen und Geräte anpassen, sei es ein Smartphone, Tablet oder Desktop-Computer. Diese Anpassungsfähigkeit verbessert das Nutzererlebnis erheblich, da die Seite auf jedem Gerät optimal angezeigt wird.

Um ein Responsive Design zu gewährleisten, ist der Einsatz von flexiblen Rasterlayoutes und skalierbarem Bildern entscheidend. CSS-Media-Queries sind dabei ein zentrales Werkzeug, um Designanpassungen für verschiedene Gerätegrößen vorzunehmen. Durch diese Queries kann die Website spezifische Styling-Regeln anwenden, abhängig von den Eigenschaften des Geräts, wie Bildschirmauflösung oder Ausrichtung.

Navigationselemente sollten vereinfacht und gut erreichbar sein, um die Bedienung auf Touchscreens zu erleichtern. Eine klare und logische Navigation trägt dazu bei, dass Nutzer problemlos durch die Seite finden.

Schließlich sollte die Performance der mobilen Website kontinuierlich überprüft und optimiert werden, um sicherzustellen, dass Ladezeiten und Interaktivität den hohen Erwartungen der mobilen Nutzer entsprechen. Ein konsequent umgesetztes Responsive Design trägt nicht nur zur verbesserten Nutzung bei, sondern hat auch positive Auswirkungen auf das Ranking in Suchmaschinen wie Google.

Sicherheitsaspekte

Im digitalen Zeitalter sind Sicherheitsaspekte eine unverzichtbare Komponente bei der Verwaltung und Optimierung einer Website. Für die Suchmaschinenoptimierung ist die Sicherheit einer Webseite ein entscheidender Faktor, da Suchmaschinen wie Google sichere Websites bevorzugen und gefährdete Seiten möglicherweise niedriger einstufen.

Ein elementarer Sicherheitsaspekt ist die Implementierung eines SSL-Zertifikats, das die Daten, die zwischen dem Webserver und den Nutzern ausgetauscht werden, verschlüsselt. Eine Website mit HTTPS in der URL signalisiert Sicherheit und Vertrauenswürdigkeit und kann das Ranking positiv beeinflussen.

Darüber hinaus ist der Schutz gegen Hackerangriffe essenziell. Regelmäßige Updates des Content-Management-Systems (CMS), der Plugins und der eingesetzten Software sind unerlässlich, um Sicherheitslücken zu schließen. Sicherheitstools und Firewalls können helfen, die Website vor Angriffen wie DDoS-Attacken oder dem Einschleusen von Malware zu schützen.

Ein sicherer Zugang zur administrativen Seite durch starke Passwörter und Zwei-Faktor-Authentifizierung erhöht die Sicherheit erheblich. Es ist wichtig, regelmäßige Backups der Website durchzuführen, um Datenverluste im Fall eines Sicherheitsvorfalls zu minimieren.

Die Sicherheitsaspekte einer Website sollten kontinuierlich überprüft und verbessert werden, um den Schutz der Nutzer und die Integrität der Webseite zu gewährleisten. Eine sichere Website fördert nicht nur das Vertrauen der Nutzer, sondern trägt auch wesentlich zur langfristigen SEO-Performance und Sichtbarkeit in den Suchergebnissen bei.

Vorteile eines SSL-Zertifikats

Ein SSL-Zertifikat zählt zu den grundlegenden Sicherheitsmaßnahmen, die eine Website ergreifen kann, um die Datenintegrität und Sicherheit im Internet zu gewährleisten. Eines der wichtigsten Merkmale eines SSL-Zertifikats ist die Verschlüsselung des Datenverkehrs zwischen dem Webserver und den Nutzern. Dies schützt sensible Informationen, wie persönliche Daten und Zahlungsdetails, vor potenziellen Angreifern und Man-in-the-Middle-Attacken.

Der Einsatz eines SSL-Zertifikats hat nicht nur sicherheitstechnische Vorteile, sondern spielt auch eine wesentliche Rolle für die Suchmaschinenoptimierung einer Website. Google hat HTTPS als einen Ranking-Faktor bestätigt, was bedeutet, dass eine mit SSL gesicherte Seite eine bessere Position in den Suchergebnissen erreichen kann im Vergleich zu ungesicherten Webseiten.

Ein weiterer Vorteil ist, dass ein SSL-Zertifikat das Vertrauen der Nutzer stärkt. Wenn Nutzer das Schlosssymbol in der Adressleiste ihres Browsers sehen und wissen, dass die Website sicher ist, sind sie eher geneigt, Transaktionen durchzuführen oder Informationen bereitzustellen.

Zudem schützt ein SSL-Zertifikat vor Phishing-Angriffen. Websites, die ein gültiges SSL-Zertifikat besitzen, machen es für Angreifer schwieriger, gefälschte Webseiten zu erstellen, die den Originalen ähneln.

Insgesamt sind die Vorteile eines SSL-Zertifikats vielfältig und tragen wesentlich zu einer besseren SEO-Performance, erhöhter Nutzerbindung und einer allgemein höheren Sicherheit bei. Der Schutz, den SSL bietet, ist eine Grundlage für den modernen Internetbetrieb und sollte ein integraler Bestandteil jeder Webseite sein.

Schutz gegen Hackerangriffe

Der Schutz gegen Hackerangriffe ist von entscheidender Bedeutung für die Sicherheit und Integrität einer Website. In einer Zeit, in der Cyberbedrohungen zunehmend komplexer werden, ist es unerlässlich, proaktive Maßnahmen zu ergreifen, um die Website und die Daten der Nutzer zu schützen.

Ein erster Schritt zur Absicherung ist die regelmäßige Aktualisierung des Content-Management-Systems (CMS) und aller installierten Plugins. Sicherheitsupdates schließen bekannte Sicherheitslücken, die Angreifer ausnutzen könnten. Ferner ist der Einsatz von Firewalls empfehlenswert, die als Barriere zwischen Ihrer Website und potenziellen Bedrohungen wirken.

Die Implementierung von Zwei-Faktor-Authentifizierung für den Zugang zur administrativen Seite erhöht die Sicherheit erheblich, da Angreifer nicht nur ein Passwort, sondern auch ein zweites Authentifizierungsmerkmal benötigen. Starke, einzigartige Passwörter sind ebenfalls unverzichtbar.

Es ist wichtig, regelmäßige Sicherheitsüberprüfungen und Penetrationstests durchzuführen, um potenzielle Schwachstellen in der Website zu identifizieren. Ebenso sollten regelmäßige Backups der Daten vorgenommen werden, um im Falle eines Angriffs eine schnelle Wiederherstellung zu ermöglichen.

Durch den Einsatz dieser Sicherheitsstrategien können Websites besser gegen Hackerangriffe geschützt werden, was nicht nur die Vertrauenswürdigkeit der Webseite erhöht, sondern auch die SEO-Performance positiv beeinflusst. Eine sichere Umgebung schafft Vertrauen und schützt die Interessen der Nutzer.

Strukturierte Daten und Metadaten

Strukturierte Daten und Metadaten sind entscheidende Komponenten im technischen SEO, die zur verbesserten Sichtbarkeit und Darstellung einer Website in Suchmaschinen beitragen. Strukturierte Daten bieten einen standardisierten Weg, Suchmaschinen zusätzliche Informationen über den Inhalt einer Seite zu liefern. Mithilfe von Markup-Sprachen wie Schema.org können Websites spezifische Datenpunkte, wie Rezepte, Veranstaltungen oder Produkte, hervorheben.

Die Implementierung strukturierter Daten ermöglicht es Suchmaschinen, Rich Snippets in den Suchergebnissen anzuzeigen, was die Klickrate verbessert, indem es Nutzern mehr Kontext bietet. Diese erweiterten Suchergebniselemente können die Aufmerksamkeit potenzieller Besucher auf sich ziehen und damit direkt zur Erhöhung des Traffics beitragen.

Metadaten hingegen umfassen Elemente wie Seitentitel und Meta-Beschreibungen, die ebenfalls von großer Bedeutung für das SEO sind. Der Seitentitel erscheint als Hauptüberschrift in den Suchergebnissen und sollte prägnant sowie relevant sein. Eine gut formulierte Meta-Beschreibung bietet Nutzern eine Vorschau dessen, was sie auf der Seite erwartet, und fördert somit die Klickrate auf das Suchergebnis.

Beide, strukturierte Daten und Metadaten, sollten sorgfältig gepflegt werden, um die Relevanz und Sichtbarkeit der Website zu maximieren. Regelmäßige Überprüfungen und Aktualisierungen stellen sicher, dass sämtliche Präsentationselemente optimal auf die Zielgruppe und die Algorithmusanforderungen abgestimmt sind.

Durch die strategische Integration dieser Elemente kann die Website effektiver in Suchmaschinen angezeigt werden, was letztlich zur Verbesserung der Gesamtleistung beiträgt.

Verwendung von strukturierten Daten

Die Verwendung von strukturierten Daten ist eine fortschrittliche Technik, die Suchmaschinen hilft, den Inhalt Ihrer Website besser zu verstehen und darzustellen. Indem Sie strukturierte Daten einsetzen, liefern Sie zusätzliche Informationen in einem strukturierten Format, das den Suchmaschinen ermöglicht, kontextuelle Details zu extrahieren und zu nutzen.

Eine der häufigsten Markup-Sprachen zur Beschreibung strukturierter Daten ist Schema.org. Mit diesem Markup können Sie spezifische Datentypen wie Produkte, Rezensionen, Veranstaltungen oder Rezepte auszeichnen. Dies verbessert die Wahrscheinlichkeit, dass Ihre Website in den Suchergebnissen als Rich Snippets erscheint, was die Sichtbarkeit und Attraktivität Ihres Eintrags erhöht.

Rich Snippets bieten Nutzern wertvolle Informationen direkt in den Suchergebnissen, beispielsweise Bewertungen, Preise oder Veranstaltungsdaten. Diese zusätzlichen Informationen können die Klickrate massiv steigern, da sie Nutzern eine kompakte Übersicht bieten und sie zu einer Interaktion anregen.

Die Implementierung strukturierter Daten sollte mit Präzision erfolgen, um sicherzustellen, dass alle relevanten Inhalte korrekt markiert sind. Regelmäßige Tests und Validierungen durch Tools wie den Google Structured Data Testing Tool sind empfehlenswert, um die Korrektheit und Effektivität der Markups zu gewährleisten.

Zusammenfassend sind strukturierte Daten ein mächtiges Werkzeug, um die SEO-Performance zu verbessern und die Sichtbarkeit der Website zu erhöhen. Indem Sie es den Suchmaschinen erleichtern, Ihren Inhalt zu interpretieren, tragen Sie entscheidend zu einer stärkeren Präsenz in den Suchergebnissen bei.

Optimierung von Seitentiteln und Meta-Beschreibungen

Die Optimierung von Seitentiteln und Meta-Beschreibungen ist ein wesentlicher Bestandteil des SEO-Prozesses, der dazu beiträgt, die Sichtbarkeit und Klickrate einer Website in den Suchergebnissen zu verbessern. Der Seitentitel ist das erste Element, das Nutzer in den Suchergebnissen sehen, und er sollte klar und prägnant die Hauptthematik der Seite vermitteln und dabei relevante Schlüsselwörter enthalten.

Eine effektive Meta-Beschreibung bietet Nutzern eine kurze Zusammenfassung des Seiteninhalts, die sie dazu ermutigt, auf das Suchergebnis zu klicken. Sie sollte ebenso Schlüsselwörter enthalten, die eng mit dem Inhalt der Seite verbunden sind, jedoch gleichzeitig ansprechend und natürlich formuliert sein.

Beide Elemente sollten für jede Seite individuell angepasst werden, um Relevanz und Einzigartigkeit zu gewährleisten. Die Länge des Seitentitels sollte idealerweise zwischen 50-60 Zeichen liegen, während Meta-Beschreibungen bis zu 160 Zeichen umfassen können.

Durch regelmäßige Überprüfungen und Anpassungen dieser SEO-Komponenten stellen Sie sicher, dass Ihre Website aktuell und relevant bleibt, was letztlich zu besseren Rankings und einer höheren Klickrate führt. Gut optimierte Seitentitel und Meta-Beschreibungen sind nicht nur für Suchmaschinen, sondern auch für Nutzer entscheidend, da sie den ersten Eindruck vermitteln, den Ihre Website im digitalen Raum hinterlässt.

SEO-freundliche Meta-Beschreibungen

SEO-freundliche Meta-Beschreibungen sind entscheidend für die Maximierung der Klickrate (CTR) aus den Suchergebnissen und tragen wesentlich zur Suchmaschinenoptimierung bei. Sie bieten Nutzern eine prägnante Vorschau auf den Inhalt einer Website und beeinflussen maßgeblich, ob eine Seite in den Suchergebnissen angeklickt wird.

Um Meta-Beschreibungen SEO-freundlich zu gestalten, sollten sie relevante Schlüsselwörter enthalten, die im Inhalt der zugehörigen Seite vorkommen. Diese Schlüsselwörter signalisieren sowohl dem Nutzer als auch der Suchmaschine, dass die Seite relevante Informationen zu ihrer Suchanfrage bietet.

Eine effektive Meta-Beschreibung sollte nicht mehr als 160 Zeichen umfassen, um sicherzustellen, dass der gesamte Text in den Suchergebnissen angezeigt wird. Der Ton der Meta-Beschreibung soll ansprechend und handlungsorientiert sein, um das Interesse des Nutzers zu wecken. Die Verwendung von Handlungsaufforderungen („Erfahren Sie mehr“, „Jetzt entdecken“) kann die Klickrate zusätzlich erhöhen.

Einzigartigkeit übernimmt ebenfalls eine Schlüsselrolle: Vermeiden Sie doppelte Meta-Beschreibungen auf Ihrer Website, um jede Seite individuell hervorzuheben und ihre jeweilige Relevanz zu unterstreichen.

Durch regelmäßige Überprüfung und Aktualisierung dieser Elemente stellt man sicher, dass die Website relevant und wettbewerbsfähig bleibt, was sich positiv auf die Positionierung in den Suchergebnissen und das Nutzerengagement auswirkt.

Richtlinien für Seitentitel

Seitentitel sind essenziell für die Suchmaschinenoptimierung und sollten klar, prägnant und aussagekräftig sein. Idealerweise umfassen sie 50-60 Zeichen, um vollständig in den Suchergebnissen angezeigt zu werden. Integrieren Sie relevante Schlüsselwörter, die den Inhalt der Seite präzise widerspiegeln, damit sowohl Nutzer als auch Suchmaschinen den Fokus sofort erkennen. Die Einzigartigkeit jedes Seitentitels ist wichtig, um jede Seite individuell zu positionieren und doppelten Inhalt zu vermeiden. Durchdachte Titel steigern das Ranking und die Klickbarkeit in den Suchergebnissen.

Tech SEO Checkliste

Verwende diese Checkliste, um die technischen SEO-Aspekte deiner Website zu optimieren:

Website-Struktur und URLs

Crawlbarkeit und Indexierbarkeit

Ladegeschwindigkeit optimieren

Mobile Optimierung

Sicherheitsaspekte

Strukturierte Daten und Metadaten

Regelmäßige Überprüfung und Optimierung dieser Aspekte wird die technische SEO-Performance deiner Website verbessern und zu besseren Rankings in den Suchergebnissen führen.

In enger Zusammenarbeit mit Ihnen konzeptionieren wir ganzheitliche Content-Marketing-Kampagnen und entwickeln ausgereifte Seeding-Strategien mit höchster Wirksamkeit. Den Fokus legen wir hierbei auf die Vermarktung informativer Inhalte statt auf die reine Bewerbung von Dienstleistungen oder Produkten.

Der SEO-Content ist veröffentlicht und die Werbekampagnen laufen – doch wie werden Website-Besucher:innen nun zu glücklichen Kund:innen? Wir helfen Ihnen dabei, datengetriebene Lösungen zu entwickeln, die genau diese Fragen für Sie beantworten.